- 作成日 : 2025年9月24日

ChatGPTに導入できるRAGとは?導入するメリット・注意点も解説

RAG(検索拡張生成)は、大規模言語モデル(LLM)が持つ知識を、外部の最新情報や特定の専門知識で補完し、回答の正確性を向上させるための技術です。社内データや専門情報をChatGPTと連携させることで、最新の情報を反映しやすく、正確性の向上が期待できます。

当記事では、RAGの仕組みや導入メリット、実装方法について解説します。専門知識の活用や業務効率化を実現したいエンジニアの方にとって、ChatGPTとRAGの組み合わせがどのようなビジネス価値を生み出すのか、そして導入時の注意点も含めて詳しく説明します。

※(免責)掲載情報は記事作成日時点のものです。最新の情報は各AIサービスなどの公式サイトを併せてご確認ください。

目次

ChatGPTに導入できるRAGとは?

RAG(Retrieval-Augmented Generation)とは、ChatGPTなどの大規模言語モデル(LLM)の回答精度と信頼性を向上させるための技術フレームワークです。従来のChatGPTは学習データの範囲内でしか回答できないという制約がありましたが、RAGを導入することで外部の知識ソースを参照しながら回答を生成できます。

企業やチームが持つ独自のドキュメント、データベース、ナレッジベースなどと連携させることで、ChatGPTを「自社専用のAIアシスタント」へと進化させることが可能です。たとえば、社内規定、製品マニュアル、業務フロー図などをRAGシステムに取り込めば、それらの情報に基づいた正確な回答を得られます。

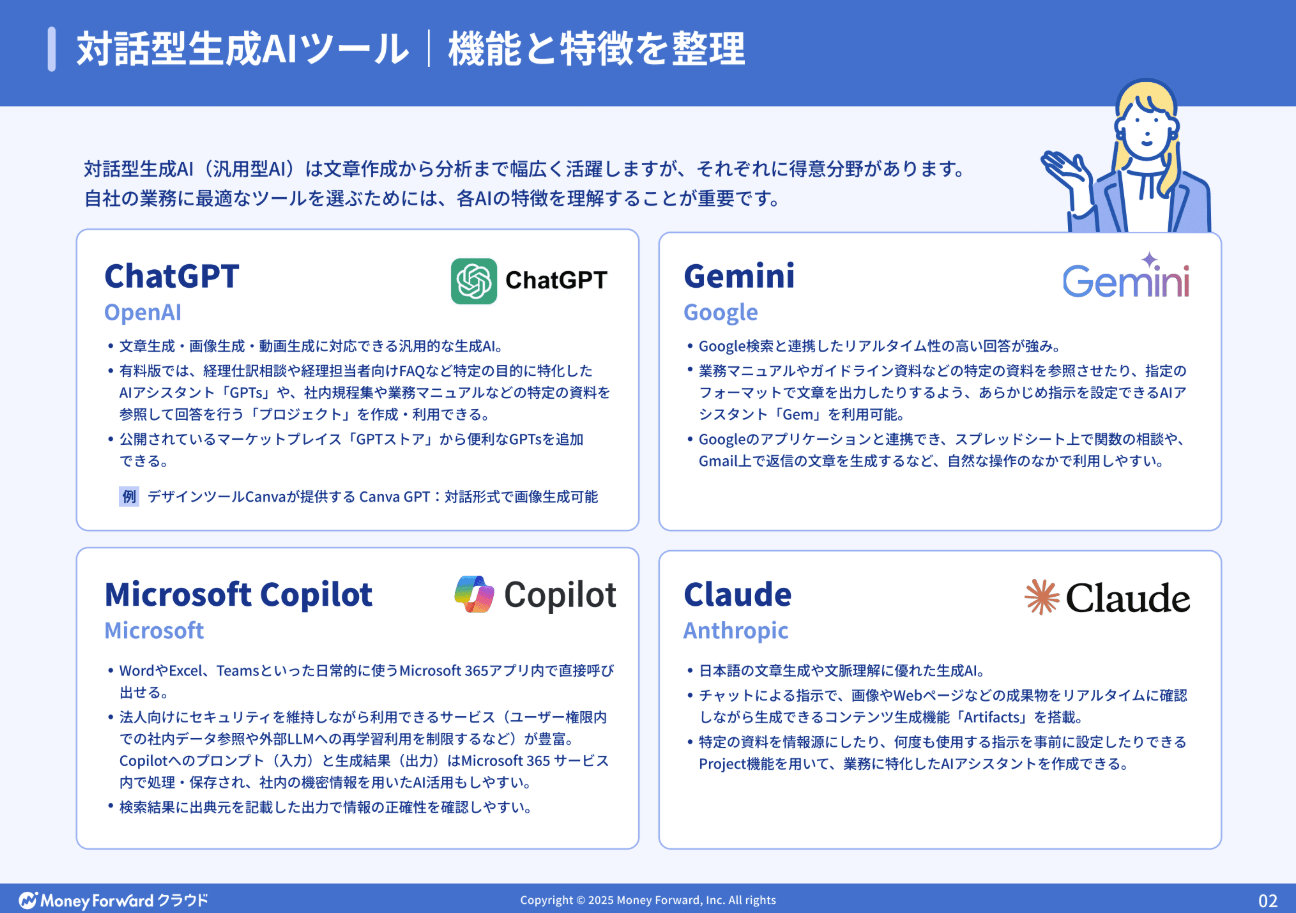

この記事をお読みの方におすすめのガイド4選

続いてこちらのセクションでは、この記事をお読みの方によく活用いただいている人気の資料・ガイドを簡単に紹介します。すべて無料ですので、ぜひお気軽にご活用ください。

※記事の内容は、この後のセクションでも続きますのでぜひ併せてご覧ください。

AI活用の教科書

経理・人事・経営企画といった企業の基幹業務における具体的なユースケースをご紹介。

さらに、誰もが均質な成果を出せる「プロンプトのテンプレート化」や、安全なガバナンス構築など、個人利用から企業としての本格活用へステップアップするためのノウハウを凝縮しました。

人事労務担当者向け!Chat GPTの活用アイデア・プロンプトまとめ14選

人事労務業務に特化!人事労務・採用担当者がChat GPTをどのように活用できるのか、主なアイデアを14選まとめたガイドです。

プロンプトと出力内容も掲載しており、PDFからコピペで簡単に試すことも可能です。

経理担当者向け!Chat GPTの活用アイデア・プロンプトまとめ12選

経理業務に特化!経理担当者がChat GPTをどのように活用できるか、主なアイデアを12選まとめたガイドです。

お手元における保存版としてはもちろん、従業員への印刷・配布用としてもぜひご活用ください。

法務担当者向け!Chat GPTの活用アイデア・プロンプトまとめ12選

法務担当者がchat GPTで使えるプロンプトのアイデアをまとめた資料を無料で提供しています。

chat GPT以外の生成AIでも活用できるので、普段利用する生成AIに入力してご活用ください。

ChatGPTを使ったRAGの仕組み

RAGの基本的な仕組みは「検索」と「生成」の2つのステップから構成されており、これらが連携することでChatGPTの応答品質を大幅に向上させます。

検索

RAGにおける検索プロセスは、ユーザーの質問から関連情報を効率的に取得するためのステップです。このプロセスでは、ユーザーのクエリを分析し、関連性の高いドキュメントやデータを特定します。検索の精度がRAG全体のパフォーマンスを左右するため、適切な検索方式の選択が不可欠です。

検索プロセスでは、まずユーザーの入力からクエリを抽出します。次に、このクエリを用いて事前に用意された知識ベースから情報を検索します。たとえば、社内FAQデータベースや製品マニュアル、営業資料などがこれに該当します。検索結果は関連性のスコアによってランク付けされ、最も適切なコンテキスト情報が選別されます。

検索の効率を高めるために、多くの企業ではベクトルデータベースを活用しています。これにより、単純なキーワードマッチングではなく、意味的な類似性に基づいた検索が可能になります。

生成

RAGの「生成」プロセスは、検索ステップで取得した情報を基に、一貫性があり的確な回答を作成する段階です。このプロセスでは、ChatGPTのような言語モデルが、検索で得られたコンテキスト情報を参照しながら回答を構築します。これにより、モデルの持つ一般知識と特定の専門知識を融合させた、より価値の高い応答が可能になります。

生成プロセスでは、まず検索結果を適切な形式に整形し、プロンプトエンジニアリングを通じてChatGPTに指示を与えます。たとえば「以下の情報を参照して質問に答えてください」といった指示とともに、検索で得られた情報を提供します。ChatGPTはこれらの情報を理解・分析し、ユーザーの質問に対する回答を生成します。

効果的な生成のためには、適切なプロンプト設計が不可欠です。プロンプトには、情報の引用方法や回答の構成方法、さらには回答の中でソースを明示するかどうかといった詳細な指示を含めることができます。これにより、単なる情報の羅列ではなく、論理的で理解しやすい回答を生成できます。

ChatGPTに導入するRAGの検索方式

ChatGPTにRAGを導入する際、情報検索の方法は生成される回答の質に影響します。各検索方式の特徴、メリット・デメリット、適した用途について詳しく解説します。

キーワード検索

キーワード検索は、ユーザーの質問から抽出したキーワードを使って、関連するドキュメントを検索する方法です。この方法はTF-IDF(TermFrequency-InverseDocumentFrequency)やBM25などのアルゴリズムを利用して実装されることが一般的です。

キーワード検索の最大の利点は、シンプルで実装が容易であることです。既存の全文検索エンジン(ElasticsearchやSolarなど)を活用できるため、比較的少ないリソースで導入が可能です。また、特定の専門用語や固有名詞を含むクエリに対しては、非常に高い精度で関連ドキュメントを検索できます。

一方、キーワード検索の限界は、意味的な類似性を捉えられない点にあります。たとえば、「経費精算の方法」と「出張費の清算手続き」は意味的に関連していても、共通するキーワードがなければ関連付けられません。また、多義語や同義語の処理も苦手とします。

ベクトル検索

ベクトル検索は、意味的な類似性に基づいてドキュメントを検索する方法です。テキストを数百次元の数値ベクトル(埋め込み/エンベディング)に変換し、ベクトル空間上での距離や類似度に基づいて関連情報を取得します。

ベクトル検索の最大の強みは、文脈や意味を理解できる点にあります。たとえば「リモートワークのセキュリティ対策」という質問に対して、「在宅勤務時のVPN接続手順」といったキーワードは異なるものの意味的に関連する情報を検索できます。

ただし、ベクトル検索には、計算コストが高い、実装が複雑、そして特定のキーワードに対する正確な一致検索が苦手といった課題もあります。また、適切な埋め込みモデルの選択やベクトルデータベースの管理など、技術的な知識も必要です。

ハイブリッド検索

ハイブリッド検索は、キーワード検索とベクトル検索の両方の検索結果を組み合わせることで、より高精度で包括的な情報検索を実現する方法です。特に企業の複雑なナレッジベースを活用する場合に効果を発揮します。

ハイブリッド検索の実装方法にはいくつかのアプローチがあります。パラレルアプローチでは、キーワード検索とベクトル検索を同時に実行し、両方の結果をスコアリングして統合します。一方、シリアルアプローチでは、まず広範囲のドキュメントをキーワード検索で絞り込み、その後ベクトル検索で意味的に関連性の高いものを選別するという二段階の処理を行います。

ハイブリッド検索のメリットとしては、キーワードの正確さと意味的な関連性を両立できること、さまざまなタイプのクエリに対する柔軟性、そして検索精度の向上が挙げられます。一方で、実装の複雑さやシステムリソースの要求が高いといったデメリットもあります。

RAGを導入しないChatGPTだけの単独運用によって生じる課題

単独運用のChatGPTでは、ビジネスに直接役立つ具体的な回答よりも、一般的な情報提供にとどまってしまうケースが多く、企業のDX推進における高度な活用には限界があります。

知識が最新ではない

ChatGPTの基本モデルは、特定の時点までのデータで学習されており、その後に発生した出来事や発表された情報は知りません。急速に変化するビジネス環境では、最新の市場動向、競合情報、規制変更などへの即応が求められますが、ChatGPTはこれらの最新情報を反映できません。

情報の鮮度の欠如は、意思決定の遅れや誤った判断につながる可能性があります。たとえば、古い規制情報に基づいたアドバイスを提供してしまうことで、コンプライアンス違反のリスクが生じることもあります。

専門性の高い分野に対応しきれない

ChatGPTは幅広い知識を持っていますが、企業の専門分野や特定業界の深い知識については限界があります。特に、企業独自の製品仕様、専門用語、技術的詳細に関しては十分な情報を持ち合わせていないことが多いです。

専門分野での知識不足は、不完全な知識に基づいて説得力のある回答を生成してしまうことで、ユーザーに誤った印象を与え、誤った意思決定を導く危険性もあります。たとえば、医療や法律、金融といった専門分野では、一般的な知識だけでは対応できない複雑なケースが多く、ChatGPTの回答だけを信頼することはリスクを伴います。

独自業務への対応が難しい

RAGを導入せずにChatGPTを単独運用する場合、企業独自の業務プロセスや社内システムへの対応が極めて困難になります。これは、ChatGPTが一般的な知識に基づいて学習されており、個別企業の独自の業務フローや組織構造についての情報を持っていないためです。

これらの独自業務に関する質問に対して、ChatGPTは一般的な回答しか提供できず、具体的な手順やルールを案内できません。たとえば「当社の経費精算システムでの申請方法」について質問されても、一般的な経費精算の概念は説明できても、その企業特有のシステム操作は説明できません。

回答の信頼性にばらつきがある

ChatGPTを単独で運用する際の重大な課題として、回答の信頼性が一定でないことが挙げられます。これは「ハルシネーション(幻覚)」と呼ばれる現象が原因であり、ChatGPTが実在しない情報や不正確な内容を自信を持って提示してしまうことがあります。

意思決定や顧客対応に不正確な情報が使われると、ビジネス上の損失や信用低下につながる可能性があります。さらに、ChatGPTは自身の回答に自信を持っているように見える傾向があり、間違った情報でも説得力を持って提示することがあります。これにより、ユーザーが誤情報を見抜けず、誤った判断をしてしまうリスクが高まります。

回答の根拠を提示できない

企業環境、特に意思決定や業務判断を行う場面では、情報の出所や根拠が必要です。しかし、ChatGPTの回答は大量の学習データから統計的に生成されるため、特定の情報源を参照できません。回答の根拠を示せないことは、透明性と説明責任の観点から課題となります。

また、問題が発生した際の追跡可能性(トレーサビリティ)も確保できません。たとえば、誤った情報に基づいて意思決定を行った場合、その情報源を特定して是正することが困難になります。企業のコンプライアンスや監査の観点からも、情報の出所を明確にできないことは障壁となります。

ChatGPTとRAGの組み合わせで実現できること

ChatGPTとRAGを組み合わせることで、企業のDX推進は加速します。以下では、具体的な業務シーンでの活用例を詳しく紹介します。

社内FAQの自動応答

社内規定、福利厚生情報、各種申請手続きなど、頻繁に問い合わせのある情報をRAGのデータベースに格納しておくことで、従業員はいつでも必要な情報に即座にアクセスできます。

このシステムの最大の強みは、社内特有の専門用語や略語を正確に理解し解釈できる点です。たとえば「来月のPJTのMTGについて」といった社内独自の表現にも適切に対応できます。また、人事システムや社内Wikiなど複数の情報源から統合的に回答を提供することが可能です。RAGを活用した社内FAQシステムは、24時間365日利用可能なため、リモートワークやグローバルチームの情報アクセス格差も解消します。

カスタマーサポートの効率化

製品マニュアル、FAQ、過去の対応事例、最新のアップデート情報などをRAGのデータベースに統合することで、顧客からの問い合わせに対して迅速かつ正確な回答を提供できます。

特に効果的なのは、顧客固有の情報と一般的な製品知識を組み合わせた個別対応が可能になる点です。たとえば、顧客のアカウント情報や過去の購入履歴を参照しながら、該当製品に関する具体的なトラブルシューティングを案内できます。

一般的なChatGPTだけでは「その情報は最新ではない可能性があります」といった曖昧な回答になりがちな問題も、RAGを導入することで解決します。サポート品質の向上により、顧客満足度が向上し、リピート率の改善にもつながります。

ヘルプデスク業務の自動化

社内システムのマニュアル、トラブルシューティングガイド、よくある質問とその解決策をRAGのデータベースに組み込むことで、従業員からのIT関連問い合わせに24時間対応可能なシステムが構築できます。

このシステムの最大の利点は、一般的なIT知識と企業固有のシステム情報を組み合わせた解決策を提供できることです。たとえば、「VPNに接続できない」という問い合わせに対して、一般的なネットワークトラブルシューティングに加え、その企業特有のVPN設定手順や社内の認証方法に基づいたアドバイスが可能です。

RAGを導入することで、システム障害やメンテナンス情報なども自動的に回答に反映されるため、リアルタイムの状況に応じた適切なガイダンスを提供できます。さらに、問題が解決しない場合は、自動的に適切なIT担当者へエスカレーションする機能も実装可能です。

チャットボットによる有人対応の補助

ChatGPTとRAGを組み合わせたチャットボットは、有人対応を補助する強力なツールとなります。カスタマーサポート担当者やセールス担当者が顧客と対話する際、バックグラウンドでRAGシステムが関連情報を即座に検索・提示することで、対応の質と速度が飛躍的に向上します。

この補助システムの優れた点は、担当者が会話中にリアルタイムで必要な情報を得られることです。たとえば、顧客から特定の製品仕様について質問があった場合、担当者が検索する手間なく、関連する技術仕様や比較データが自動的に表示されます。

RAGの導入により、新人担当者でもベテラン並みの対応が可能になります。製品知識、過去の事例、社内ポリシーなどを即座に参照できるため、トレーニング期間の短縮と早期の戦力化が実現します。また、対応の均質化により、担当者による品質のばらつきも解消されます。

専門知識の共有と活用

研究レポート、技術文書、ベストプラクティス、プロジェクト記録などの専門資料をRAGのデータベースに取り込むことで、組織の集合知を誰もが簡単に活用できる環境が整います。

このシステムの強みは、複雑な専門情報を文脈に応じて適切に要約・説明できる点です。たとえば、エンジニアが過去の類似プロジェクトの情報を検索した場合、技術的な詳細を含む回答が得られますが、経営層が同じ情報を求めた場合は、ビジネスインパクトを中心にした要約が提供されます。

RAGを活用することで、専門家の退職や部署移動による知識流出のリスクも軽減されます。貴重なノウハウや暗黙知をシステムに蓄積することで、継続的な知識の保持と活用が可能になり、組織全体の知的生産性向上にも貢献します。

製品開発プロセスの最適化

市場調査データ、競合分析、顧客フィードバック、過去の製品情報などをRAGのデータベースに統合することで、開発チームは包括的な情報に基づいた意思決定ができます。

このアプローチの強みは、大量の製品関連データから有意義なパターンや洞察を抽出できる点です。たとえば、類似製品の開発履歴を分析して潜在的な問題点を事前に特定したり、顧客フィードバックから最も要望の高い機能を優先順位付けしたりすることが可能です。

RAGの導入により、設計仕様書や技術文書の作成も効率化されます。過去の類似プロジェクトの文書を参照しながら、新製品の文書を自動生成することで、ドキュメント作成の負担が大幅に軽減されます。

マーケティング分析の高度化

市場調査レポート、ソーシャルメディアデータ、競合情報、顧客アンケート、過去のキャンペーン結果などをRAGのデータベースに統合することで、包括的かつ深い市場理解に基づいたマーケティング戦略の構築が可能になります。

この手法の優れた点は、異なるソースからの情報を統合して多角的な分析ができることです。たとえば、「20代の顧客セグメントの最近の購買傾向は?」という質問に対して、自社の販売データ、業界レポート、SNSでのトレンド分析を組み合わせた総合的な回答が得られます。

ChatGPTにRAGを導入するメリット

以下では、ChatGPTにRAGを導入する具体的なメリットについて、実際の業務改善の視点から詳しく解説します。

最新かつ正確な情報を提供できる

ChatGPTにRAGを導入する最大のメリットは、常に最新かつ正確な情報に基づいた回答が得られる点です。通常のChatGPTモデルは学習データの期間に制限があり、それ以降の情報や変更点については把握していません。

RAGを導入すると、質問に関連するデータをリアルタイムで検索し、その情報を基に回答を生成するため、常に最新の状態を反映できます。たとえば、頻繁に更新される社内規定や製品マニュアルについての質問があった場合、RAGシステムは最新版のドキュメントを参照して回答できます。

また、RAGは情報の出所を明確に示すことができるため、回答の信頼性を担保できます。従来のAIモデルでは「もっともらしいが誤った情報」を生成するリスクがありましたが、RAGでは参照元のデータを明示することで、情報の検証が容易になります。

社内情報や非公開データに基づく回答が可能になる

企業における最も価値ある資産の1つは、長年蓄積された社内の専門知識やノウハウです。しかし、従来のChatGPTは公開データでのみ学習されているため、企業固有の情報や非公開データに基づく回答を生成できませんでした。

RAGを導入することで、この壁を突破できます。たとえば、社内の業務マニュアル、過去の提案書、顧客対応履歴、社内FAQデータベースなどを検索対象として設定することで、ChatGPTはこれらの非公開情報を参照しながら回答を生成できます。

特に効果を発揮するのは、新入社員のオンボーディングや部署間の知識共有の場面です。たとえば「プロジェクトXの過去の失敗事例は?」といった質問に対して、社内の過去の報告書や議事録を基に具体的な回答が得られるため、暗黙知の形式知化と効率的な共有が実現します。

ハルシネーションのリスクを軽減できる

AIの回答における課題の1つがハルシネーションです。特にビジネス利用においては、このような誤情報が意思決定に影響を与える可能性があり、深刻な問題となります。

RAGは回答の根拠となる情報を実際のデータソースから取得し、その情報に基づいて回答を生成するため、ハルシネーションのリスクを大幅に軽減できます。つまり、「思い込み」ではなく「参照」に基づく回答が可能になります。

たとえば、製品の仕様について質問された場合、通常のChatGPTは学習データから推測して回答するため、最新の仕様変更を反映できないことがあります。一方、RAGを導入したシステムでは、最新の製品マニュアルを参照して正確な情報を提供できます。回答とともに参照元の情報を表示することで、ユーザーは回答の信頼性を自分で確認できます。

コスト削減やリソース最適化につながる

ChatGPTにRAGを導入することで得られる経済的メリットは多岐にわたります。最も直接的な効果は、問い合わせ対応コストの削減です。従来は人間のオペレーターが対応していた社内外からの一般的な質問に、AIが自動で正確に回答できます。

もう1つ注目すべきは、RAG導入によるリソース最適化の効果です。たとえば、社内のヘルプデスク業務では、同じような質問が繰り返されることが多く、担当者の時間が非効率に使われがちです。RAGを活用したChatGPTなら、蓄積された過去の対応履歴から最適な回答を提供できるため、担当者は複雑な問題解決に集中できます。

業務やユーザーに合わせた柔軟な応答が可能になる

通常のChatGPTでは一般的な回答しか提供できませんが、RAGでは企業独自の文脈を反映した回答が可能になります。たとえば、同じ「在庫管理について教えて」という質問でも、RAGシステムは質問者の部署や役割に応じて異なる回答を提供できます。営業担当者には販売に関連した在庫情報を、物流担当者には倉庫管理のベストプラクティスを、経営層には在庫コスト最適化の視点からの情報を提供するといった具合です。

さらに、ユーザーの過去の問い合わせ履歴や行動パターンを参照することで、個人化された応答も可能になります。「前回と同じ手順で」といった曖昧な指示も、過去のやり取りを踏まえて適切に対応できるため、ユーザー体験が大幅に向上します。

データ更新とメンテナンスの手間を削減できる

RAGの最大の強みは、ChatGPTの基礎モデルを変更することなく、参照するデータベースの内容を更新するだけで最新情報を反映できる点です。たとえば、製品マニュアルが改訂された場合、単に新しいPDFファイルをナレッジベースに追加するだけで、AIは自動的に最新の情報に基づいて回答を生成します。

さらに、RAGはデータの追加・削除が柔軟にできるため、一時的なキャンペーン情報の追加や、古くなった情報の削除といった運用も容易です。これにより、常に最適な状態のナレッジベースを維持できます。

メンテナンス面では、RAGシステムは使用されるデータの分析も可能です。どの文書が頻繁に参照されているか、どの情報に対するクエリが多いかなどの分析結果から、重点的に更新・整備すべき分野を特定できます。

要約や情報補完によって出力の質が向上する

RAGでは、質問に関連する複数のソースから情報を取得し、それらを包括的に分析して統合できます。たとえば、四半期報告書、市場分析レポート、競合情報などを組み合わせた経営戦略の要約や、複数の技術文書を統合した問題解決策の提案などが可能になります。

また、情報の文脈を考慮した補完もメリットです。一部のデータだけでは不明確だった情報も、関連する他のソースからの情報を組み合わせることで、より完全で正確な回答を生成できます。

さらに、RAGは異なる視点や意見の提示にも優れています。同じトピックに関する異なる立場や見解を含むドキュメントがある場合、それらを統合して多角的な分析を提供できます。これにより、より包括的で公平な情報提供が可能になり、バランスの取れた意思決定をサポートします。

ChatGPTにRAGを導入する方法

RAGの導入は6つのステップで進めます。各ステップを順に実行することで、信頼性の高いAIシステムを構築できます。

【ステップ1】要件を定義し対象ドメインを選定する

このステップでは、何のためにRAGを導入するのかという目的を明確にし、どの業務領域に適用するかを決定します。

まず、現状の課題を洗い出しましょう。たとえば、「カスタマーサポートでの回答の一貫性がない」「社内ナレッジの検索に時間がかかりすぎる」といった具体的な問題点を特定します。次に、RAG導入によって解決したい課題と期待する効果を定量的に設定します。応答時間の短縮率や正確性の向上など、測定可能な指標を設けることが重要です。

対象ドメインの選定では、データの量と質・更新頻度・専門性の度合い・セキュリティ要件を考慮します。

【ステップ2】外部知識ソースを収集し整備する

このステップでは、適切な外部知識ソースを収集し、システムが効率的に利用できるよう整備します。

社内データソースとしては、マニュアル、FAQ文書、製品仕様書、過去の顧客対応履歴、社内Wiki、技術文書などが候補となります。外部データソースとしては、業界レポート、公開APIから取得できるデータ、学術論文なども活用できます。

また、データ整備では、情報の更新頻度も考慮して管理プロセスを設計します。自動的に新しい情報を取り込み、古い情報を更新するワークフローを確立することで、常に最新の知識ベースを維持できます。

【ステップ3】知識データをベクトル化しインデックスを構築する

知識データのベクトル化では、テキストデータを数値表現(ベクトル)に変換することで、意味的な類似性に基づいた検索が可能になります。まず、埋め込みモデル(Embedding Model)の選択が重要です。代表的なモデルには以下があります。

|

選定の際は、精度、処理速度、コスト、多言語対応の必要性などを考慮します。特に業務特性に合わせたモデル選定が重要で、たとえば日本語文書が多い場合は日本語に強いモデルを選ぶべきです。

ベクトル化されたデータは、効率的に検索できるようインデックスを構築します。一般的なベクトルデータベース/インデックス技術には以下があります。

|

ベクトルデータベースの選定では、スケーラビリティ(データ量増加への対応)、クエリ速度、メタデータのフィルタリング機能、更新容易性などを評価します。

【ステップ4】検索システムを構築しAPIを整備する

このステップでは、ユーザークエリを解析し、関連性の高い情報を知識ベースから取得するシステムを構築します。

検索システム設計では、検索の精度とレイテンシのバランスを考慮することが重要です。多くの実装では、ハイブリッド検索が採用されています。これにより、キーワードの正確な一致と意味的な関連性の両方を考慮した検索が可能になります。

検索APIの設計では、以下の機能を実装するとよいでしょう。

|

【ステップ5】プロンプトを設計し生成処理に組み込む

RAGシステムの要となるプロンプト設計では、検索結果を効果的に活用してChatGPTの回答を生成するための指示を作成します。基本的なRAGプロンプトの構造は以下の要素で構成されます。

|

特に重要なのは、検索結果の組み込み方です。単に検索結果をそのまま提供するのではなく、以下のような工夫が効果的です。

|

プロンプトには、「検索結果に基づいて回答すること」「不確かな情報については推測せず、情報不足を正直に伝えること」などの明示的な指示を含めることで、ハルシネーションを大幅に減らせます。

【ステップ6】出力結果を評価し継続的に改善する

このステップでは、システムの出力品質を測定し、弱点を特定して改善するプロセスを確立します。RAGシステムの評価には以下のような指標が用いられます。

|

評価方法としては、以下のアプローチを組み合わせると効果的です。

|

ChatGPTにRAGを導入する場合の注意点

ChatGPTをRAGと連携させることで、最新情報や専門知識に基づいた回答を提供できますが、実際の導入においてはいくつかの注意点があります。

ハルシネーションを防止する仕組みを整備する

RAGを導入するだけでハルシネーションが完全になくなるわけではありません。効果的にハルシネーションを防止するためには、複数の防止策を組み合わせることが重要です。まず、検索結果の関連性スコアの閾値設定を行いましょう。関連性が低いデータに基づいた回答を生成させないよう、最低限のスコアを設定することで精度を高められます。

また、回答の根拠となる情報源の明示も有効です。ChatGPTの回答に「この情報は○○という文書に基づいています」といった引用情報を含めることで、ユーザー側で情報の妥当性を判断しやすくなります。

応答時間の遅延を考慮する

RAGを導入したChatGPTシステムでは、単独のChatGPTと比較して応答時間が長くなることを想定しておく必要があります。これは、ユーザーからの質問に対して外部データソースを検索し、その結果を取得して回答を生成するという複数のステップが追加されるためです。

特に大規模なデータベースや複雑なクエリが必要な場合、検索処理に要する時間が大幅に増加することがあります。たとえば、何百万もの文書から最適な情報を見つけ出す場合、数秒から数十秒の遅延が発生することもめずらしくありません。遅延を最小限に抑えるためには、データベースのインデックス最適化やキャッシング、非同期処理などの技術的対策が効果的です。

セキュリティ対策を強化する

特に企業の機密情報や個人情報を含むデータベースとChatGPTを連携させる場合、データの保護には万全を期す必要があります。まず検討すべきはアクセス制御の徹底です。RAGシステムを通じて参照できる情報は、ユーザーの権限に応じて適切に制限されるべきです。たとえば、人事情報を含むドキュメントは人事部門のスタッフのみがアクセスできるよう設定すると、情報の不適切な漏洩リスクを大幅に低減できます。

また、データの暗号化も不可欠です。保存データ(データベース内の情報)と通信データ(ChatGPTとデータベース間のやりとり)の両方を適切に暗号化することで、データの盗聴や不正アクセスのリスクを軽減できます。

データベースの依存性を意識する

従来のChatGPTは事前学習した知識のみで動作するため外部システムに依存しませんが、RAGでは常に外部データベースとの連携が必要になります。このため、データベースに障害が発生した場合、システム全体の機能が著しく低下する可能性があります。

この依存性に対処するためには、冗長性の確保が効果的です。複数のデータベースを用意し、1つに障害が発生した場合でも他方で補完できるようにすると、システムの可用性を高められます。

また、フォールバックメカニズムの実装も重要です。データベース接続に問題が発生した場合、完全に機能を停止するのではなく、基本的な機能だけでも提供できるよう設計しておくことで、ユーザー体験の急激な低下を防ぐことができます。

実装と運用の複雑さに対応する

単純なChatGPT APIの利用と比較すると、データの前処理、埋め込みベクトルの生成、検索アルゴリズムの調整など、追加的な技術要素が多数存在します。これらを適切に設計・実装するには、専門的な知識とスキルが必要です。

実装の複雑さに対応するためには、段階的な導入アプローチが有効です。まずは小規模なプロトタイプから始め、徐々に機能や対象データを拡大することで、リスクを最小化しながら経験を積めます。たとえば、最初は限られた部門の特定のドキュメントセットのみを対象とし、成功体験を積んだ後に全社展開を検討するといった方法があります。

ChatGPTとRAGの融合がもたらすビジネス変革

ChatGPTにRAGを導入することは、ビジネスにおける情報活用の新たな地平を切り開きます。ただし、導入にあたっては複数の注意点が存在します。課題を適切に管理することで、RAGはChatGPTの能力を拡張し、ビジネスのナレッジマネジメントを根本から変革する可能性を秘めています。今後のAI戦略において、RAGの活用は避けて通れない要素となるでしょう。

※ 掲載している情報は記事更新時点のものです。

※本サイトは、法律的またはその他のアドバイスの提供を目的としたものではありません。当社は本サイトの記載内容(テンプレートを含む)の正確性、妥当性の確保に努めておりますが、ご利用にあたっては、個別の事情を適宜専門家にご相談いただくなど、ご自身の判断でご利用ください。

関連記事

GitHub Copilotの解約方法|事前確認から解約後までを解説

PointGitHub Copilot解約の手順と注意点 解約は請求設定から行い、多くは更新日まで利用可能です。個人契約か組織契約かで解約担当が変わるため、更新日・権限・移行準備を…

詳しくみるGemini Nanoとは?特徴やメリット・使い方・活用シーンを解説

Gemini Nanoは、Googleの「Gemini」シリーズの中で、スマホやパソコンなどのデバイス上で直接動作する最小クラスのオンデバイスAIモデルです。テキストの要約・言い直…

詳しくみるGeminiのPDF機能は何ができる?具体的な活用方法や注意点を解説

Geminiは、PDF文書の内容を正確に理解する「マルチモーダル性能」が、他社AIと比べても高いツールです。単に文字を読むだけでなく、要約や翻訳、システム連携によるデータ抽出まで、…

詳しくみるChatGPT Deep Researchとは?使い方、料金、プロンプトのコツまで解説

ChatGPT Deep Researchは、ChatGPTに備わった多段階リサーチ機能で、従来の即時応答型AIを超え、複雑な調査・分析タスクを自律的に実行する能力を持っています。…

詳しくみるChatGPTのアイコン・ロゴの使い方は?公式ロゴのDLやプロフィール画像変更方法も解説

資料作成などでChatGPTの公式ロゴ(アイコン)を使用したい場合は、OpenAIのガイドラインに従って正しく扱う必要があります。また、自身のプロフィール用アイコンも、設定画面から…

詳しくみる【Claudeの料金プラン全5種を徹底比較】他AIモデルとの比較も

ClaudeはAnthropic社が開発した対話型AIで、安全性と高精度な自然言語処理に定評があります。無料版から法人向けの大規模プランまで用意されているため、利用者は目的や予算に…

詳しくみる