- 作成日 : 2026年2月6日

Claudeに学習させない設定方法は?情報漏洩リスクや規約も解説

Claudeの入力データを学習させない設定は、プライバシー保護の観点から欠かせません。デフォルトの状態では、会話内容やアップロードしたファイルがAIのモデル改善に利用される可能性があるため、機密情報を扱う際は適切な設定変更が必要です。

この記事では、PCやスマホアプリでの具体的な設定手順、プラン別の規約の違い、情報漏洩を防ぐための運用ルールまでをわかりやすく解説します。

※(免責)掲載情報は記事作成日時点のものです。最新の情報は各AIサービスなどの公式サイトを併せてご確認ください。

目次

Web・アプリ版Claudeで学習させない設定にするには?

WebブラウザやアプリでClaudeを利用する際、学習機能の停止はユーザー自身の設定変更によって行います。この設定を行わない限り、会話履歴は将来のモデル精度の向上や安全性向上のために使用される可能性があるためです。設定手順はシンプルですが、PC版とスマホ版で画面遷移が少し異なります。

ここでは、デバイスごとの具体的な設定方法や確認手順について解説します。

【PC版】設定画面から学習をオフにする

PC版での学習拒否設定は、プロフィールアイコン内の「設定」から変更可能です。メニュー内の「プライバシー」タブを選択すると「Claudeの改善にご協力ください」という学習に関する設定項目が表示されるため、該当するトグルスイッチをオフに切り替えてください。この操作により、会話データはモデルのトレーニングに使用されなくなります。

以前はわかりにくい場所にありましたが、現在は設定メニューから簡単にアクセスできるよう改善されました。なお、この画面では「ロケーションメタデータ(位置情報)」の送信設定や、共有チャットの管理、データのエクスポートもあわせて行うことができます。設定変更後は念のため画面をリロードし、設定が保持されているか確認することをおすすめします。

【スマホ版】アプリ設定から学習をオフにする

スマホアプリ版の設定変更は、アプリ内メニューのアカウント設定から行います。画面上部またはメニュー内にあるアイコンをタップして「設定」>「プライバシー」へ進み、「Claudeの改善にご協力ください」を無効化してください。アプリ版の設定は、通常Web版と同期されますが、反映に時間がかかる場合があります。

確実なプライバシー保護のためには、PCとスマホの両方で設定画面を確認し、それぞれでオフになっているかチェックしておくと安心でしょう。モバイル端末は手軽に利用できる分、設定の確認がおろそかになりがちなので注意が必要です。

従来のオプトアウト申請は不要

現在のClaudeでは、Googleフォームなどを使った外部からのオプトアウト申請は不要となりました。サービス開始当初は専用フォームへの申請が必要でしたが、現在はユーザー設定画面(UI)にトグルスイッチが実装され、その場で即座に設定を変更できるようになったからです。

古いブログ記事やSNSの情報には、まだ申請フォームのURLが記載されている場合がありますが、それらは現在利用されていない可能性があります。最新の仕様ではアカウント設定画面からの操作が正規の手順ですので、手間をかけずにアプリやブラウザから直接設定を行ってください。

設定が反映されているか確認する方法

設定が正しく適用されているかは、再度「設定」内の「プライバシー」画面を開くことで判別できます。トグルスイッチの色がオフの状態(グレーアウトなど)になっていれば、設定は有効です。Anthropic社の規約には、ユーザーが明示的にオプトアウトした場合、そのデータはトレーニングに使用されないと明記されています。

もし設定が勝手に戻っているなどの不具合を感じた場合は、一度ログアウトしてから再ログインを試してください。それでも不安な場合はサポートへの問い合わせも検討できますが、基本的には画面上の表示が現在のステータスを表しています。

チャットごとの個別設定は不可

Claudeの学習設定はアカウント全体に適用される仕様であり、チャットルームごとの切り替えはできません。ChatGPTのような「一時的なチャット」機能は現時点でClaudeに搭載されておらず、一度「学習させない」設定にすればすべての会話が対象になり、逆にオンにすればすべてが学習対象となります。

そのため、「この会話だけは学習させたくない」という使い分けはできません。基本的には常に学習オフの設定にしておくか、どうしても学習させたいデータがある場合は、機密性の高い会話をするアカウントを別途分けるなどの対策をとる必要があります。

この記事をお読みの方におすすめのガイド4選

続いてこちらのセクションでは、この記事をお読みの方によく活用いただいている人気の資料・ガイドを簡単に紹介します。すべて無料ですので、ぜひお気軽にご活用ください。

※記事の内容は、この後のセクションでも続きますのでぜひ併せてご覧ください。

AI活用の教科書

経理・人事・経営企画といった企業の基幹業務における具体的なユースケースをご紹介。

さらに、誰もが均質な成果を出せる「プロンプトのテンプレート化」や、安全なガバナンス構築など、個人利用から企業としての本格活用へステップアップするためのノウハウを凝縮しました。

人事労務担当者向け!Chat GPTの活用アイデア・プロンプトまとめ14選

人事労務業務に特化!人事労務・採用担当者がChat GPTをどのように活用できるのか、主なアイデアを14選まとめたガイドです。

プロンプトと出力内容も掲載しており、PDFからコピペで簡単に試すことも可能です。

経理担当者向け!Chat GPTの活用アイデア・プロンプトまとめ12選

経理業務に特化!経理担当者がChat GPTをどのように活用できるか、主なアイデアを12選まとめたガイドです。

お手元における保存版としてはもちろん、従業員への印刷・配布用としてもぜひご活用ください。

法務担当者向け!Chat GPTの活用アイデア・プロンプトまとめ12選

法務担当者がchat GPTで使えるプロンプトのアイデアをまとめた資料を無料で提供しています。

chat GPT以外の生成AIでも活用できるので、普段利用する生成AIに入力してご活用ください。

入力済みのデータを削除・リセットするには?

学習設定をオフにするだけでなく、過去に入力したデータを削除したい場合も適切な手順が求められます。チャット履歴を削除することで管理画面上からデータを見えなくすることはできますが、それがサーバーから完全に消去されるタイミングとは異なる場合があるからです。

ここでは、個別のチャット履歴の削除方法やアカウントの削除、そしてデータの保持期間に関する注意点について解説します。

特定のチャット履歴を削除する

不要になった特定のチャット履歴は、サイドバーのチャットリストから個別に削除できます。削除したいチャットのタイトル部分にあるメニューアイコンを選択し、「Delete」を実行すれば、ユーザーインターフェース上からは即座に消去されます。この操作は履歴を整理し、誤操作を防ぐために有効な手段です。

機密情報を含んでしまった会話などは、放置せずにこまめに削除することをおすすめします。ただし、後述するとおり「画面から消えた=サーバーから即時完全消去」ではない点には留意し、削除後も油断しないことが大切です。

アカウント自体を削除する

Claudeの利用を完全にやめる場合は、「Settings」メニュー内の「Account」セクションからアカウント削除を実行します。この操作を行うと、すべてのチャット履歴、設定、および登録情報が削除プロセスに入ります。アカウント削除は取り消しができない不可逆的な操作であるため、慎重な判断が必要です。

必要なデータが残っていないか、事前に十分確認してから実行してください。また、有料プランを契約している場合は、アカウント削除の前にサブスクリプションの解約手続きが必要になるケースがあるため、支払い状況もあわせて確認しておきましょう。

【注意】削除しても一定期間はサーバーに保持される

チャット履歴やアカウントを削除しても、サーバー上のデータがその瞬間にゼロになるわけではありません。Anthropic社のプライバシーポリシー等によると、不正利用の検知や法的義務の履行などを目的として、削除操作後も一定期間(例:30日〜数ヶ月程度)はバックアップやログとしてデータが保持される場合があります。

これは多くのクラウドサービスで共通する仕様です。「削除ボタンを押したからもう誰にも見られない」と過信するのは危険でしょう。誤って機密データを入力してしまった場合は、削除操作を行ったうえで、念のため社内のセキュリティ担当者に報告するなど、リスクを考慮した対応をとることが望ましいです。

機密データやコードを入力しても大丈夫?

学習させない設定を行っていたとしても、機密データやプログラムコードをAIに入力することには常に一定のリスクが伴います。クラウドサービスを利用する以上、通信経路やサーバー側での予期せぬトラブル、あるいは人間の操作ミスによる漏洩の可能性を完全に排除することは難しいからです。

ここでは、セキュリティリスクの実態と、ユーザーがとるべき具体的な防衛策について解説します。

情報漏洩のリスクはゼロではない

学習設定をオフにしていても、クラウド上にデータを送信している以上、情報漏洩のリスクをゼロにすることはできません。過去には他社AIサービスにおいて、バグにより他人のチャット履歴が表示されてしまう事故が発生した事例もあります。Claude自体は高いセキュリティ基準を持っていますが、システムに絶対はありません。

したがって、「学習されない=外部に漏れない」と安易に結びつけるのは危険です。学習設定はあくまで「AIの知識として蓄積させない」ためのものであり、データ流出を100%防ぐ機能ではないと理解しておく必要があります。極めて重要な機密情報については、そもそも入力しないという判断が安全です。

個人情報や機密データはマスキングする

業務でClaudeを利用する際、顧客の個人情報や社外秘の固有名詞が含まれる場合は、マスキング処理を行ってください。たとえば「A社の田中さん」を「B社の担当者」に、「売上1億円」を「売上X円」に書き換えるといった工夫により、万が一データが流出したり学習されたりした場合でも、被害を最小限に抑えられます。

最近では、AIに入力する前に自動で個人情報を検知してマスキングしてくれるセキュリティツールも登場しています。頻繁にデータを扱う場合はそうしたツールの導入も検討すべきですが、基本的には「特定の個人や企業が特定できる情報は入力しない」という意識を徹底することが、コストのかからない有効な対策です。

入力コードは再学習される可能性がある

エンジニアがプログラムコードを入力する場合、そのコードが独自のアルゴリズムや未公開のロジックを含んでいないか注意が必要です。学習設定がオンのままコードを入力すると、そのコードパターンがAIに学習され、将来的に他のユーザーからの質問に対して、あなたのコードと酷似した回答が出力されてしまう可能性があります。

特に、APIキーやパスワードなどの認証情報がコード内に残ったままペーストしてしまうミスは致命的です。コードのレビューやリファクタリングを依頼する場合でも、認証情報は削除し、コアとなる重要なロジック部分は抽象化してから入力するよう心がけてください。

Claude Codeでも学習設定の確認が必須

Claudeを利用したコーディング支援ツール(エージェント型CLIツール「Claude Code」など)や、API経由でコードを処理させる場合でも、学習設定の確認は必須となります。開発環境と連携させている場合、意図せず大量のソースコードが送信されてしまうことがあるため、使用しているツールがデフォルトでデータを学習に利用する設定になっていないか確認しましょう。

サードパーティ製の拡張機能やプラグインを使用している場合は、Anthropic本体の設定だけでなく、そのツールのプライバシーポリシーも確認が必要です。ツールによっては独自の品質向上のためにデータを収集している場合があるため、利用規約をよく読み、信頼できるツールのみを選定することが大切です。

なぜClaudeのデータは学習に使われる?

そもそも、なぜClaudeなどの生成AIはユーザーのデータを学習に利用するのでしょうか。その主な理由は、AIモデルの性能向上と安全性確保にあります。ユーザーがどのようなプロンプトを入力し、AIがどう返答したかという実データは、開発元にとって非常に貴重な資源となります。

ここでは、学習の目的や対象となるデータの範囲、そして例外となるケースについて解説します。

モデルの精度向上と安全性を高めるため

AIがより自然で正確な対話ができるようになるためには、大量の会話データによる「強化学習」が必要です。人間がAIの回答を評価したり、実際の会話履歴を分析したりすることで、AIはより賢くなっていきます。ユーザーのデータは、まさにAIを育てるための教材として使われているのです。

また、安全性の向上も大きな目的のひとつです。差別的な発言や危険な情報の提供を防ぐために、どのような入力に対してAIが不適切な反応をしたかを分析し、ガードレール(防御壁)を強化するためにデータが活用されます。学習は単なる機能強化だけでなく、AIを安全なツールにするためにも行われています。

無料・Pro版はデフォルトで学習設定のため

Claudeの無料プランおよび個人向けのProプランでは、基本的にサービス利用の対価としてデータ提供が求められる形式になっています。デフォルトの設定では学習機能がオンになっており、これは多くの生成AIサービスで共通するビジネスモデルです。無料で高機能なAIを使える代わりに、ユーザーはデータを提供して開発に協力するという関係性です。

もちろん、前述のとおり設定でオフにすることは可能ですが、初期状態ではオンであることを認識しておく必要があります。アカウントを作成してすぐに機密情報を入力してしまうと、その時点でのデータは学習対象となる可能性があるため、使い始めの段階で設定を確認するフローを設けることが重要です。

チャット履歴や添付ファイルが対象になるため

学習の対象となるのはテキストのチャット履歴だけでなく、アップロードした添付ファイルや画像データも含まれます。Claudeは長文の読み込みや分析が得意なため、会議の議事録や仕様書などを丸ごとアップロードする機会も多いでしょうが、ファイルの中身に含まれる情報もテキスト同様に解析され、モデルのトレーニングに使用されるリスクがあります。

「ファイルなら大丈夫だろう」という認識は誤りです。添付ファイル機能を使う際も、テキスト入力と同じく機密情報のマスキングや学習設定のオフを徹底しなければなりません。どのような形式であれ、入力した情報はすべて学習データの候補になり得ると考えるべきでしょう。

不正利用の検知目的で一定期間保存されるため

学習とは別に、不正利用や悪用を防ぐためのモニタリング目的でデータが保存されることがあります。これは学習設定をオフにしていても適用されることが多く、テロ行為の予告や児童ポルノの生成など、規約違反となる使い方を検知するために自動または手動でのチェックが行われる場合があります。

この目的で保存されたデータは、基本的にはAIの回答生成能力の向上(学習)には使われません。しかし、開発元のサーバー内にデータが存在することには変わりないため、完全なプライベート空間ではないという認識を持つことが大切です。コンプライアンス遵守の観点からも、不適切な利用は避けるべきです。

【例外】APIやTeamプランは学習対象外

すべてのデータが学習に使われるわけではなく、API経由での利用や法人向けの「Teamプラン」「Enterpriseプラン」では、デフォルトで学習に利用されない規約になっています。これらは企業利用を前提としているため、データの機密性が契約レベルで保証されており、安心して業務に導入できる設計です。

特にAPIを利用する場合、Anthropic社は「原則として入力データをモデルの学習に使用しない」方針を打ち出しています。システムに組み込んで利用する場合や、高度なセキュリティが求められる環境では、Web版ではなくAPIの利用が推奨されます。

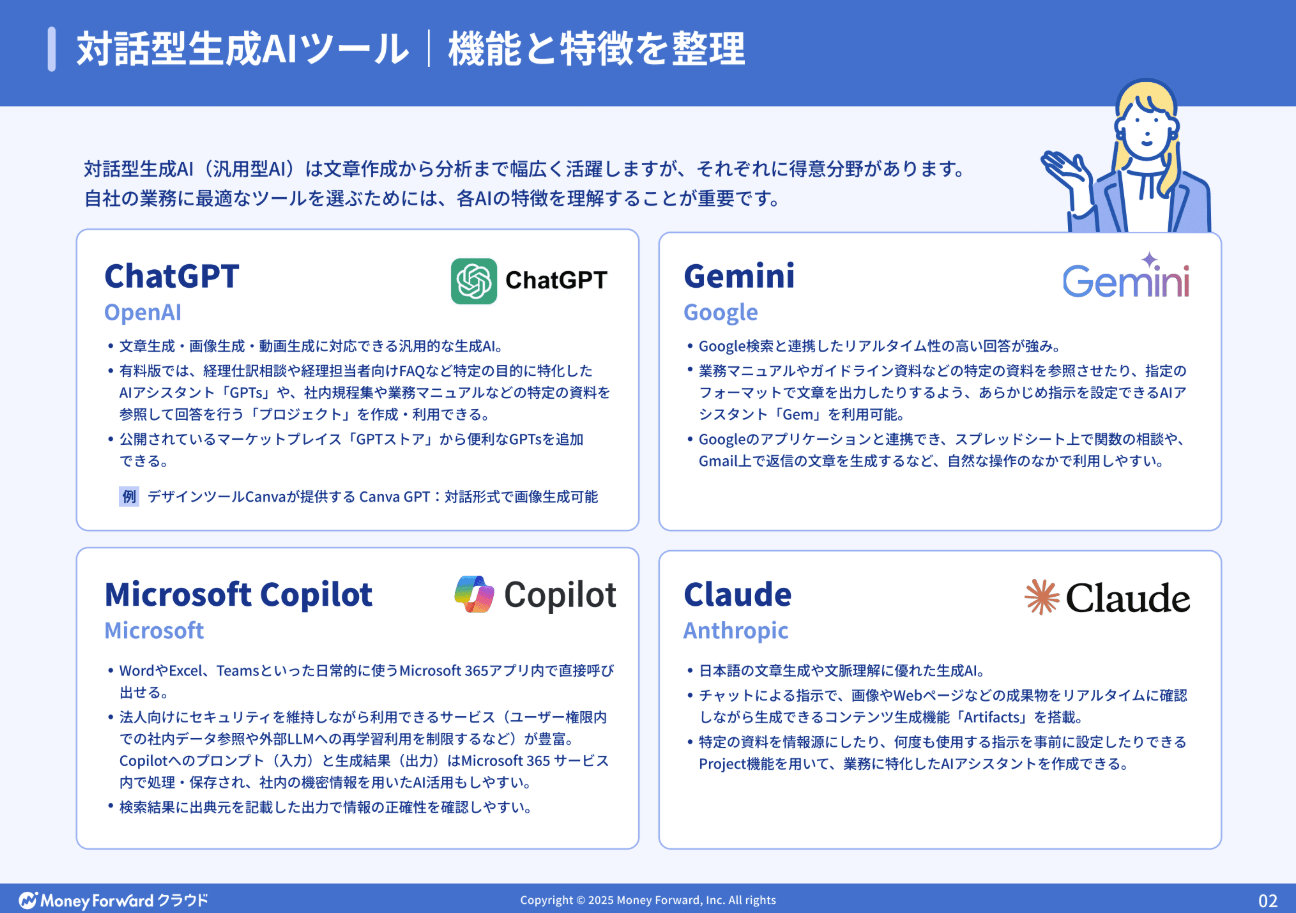

Claudeと他社AIの学習ポリシーの違いは?

Claude以外にもChatGPTやGeminiなど多くの生成AIが存在しますが、それぞれの学習ポリシーや設定方法は微妙に異なります。セキュリティ担当者や導入を検討しているユーザーにとって、他社との比較は重要な判断材料になります。

ここでは、主要な生成AIとClaudeの学習ポリシーの違いや、Claudeが「安全」と言われる背景について解説します。

ChatGPT(OpenAI)の学習設定と比較

ChatGPTもClaudeと同様に、デフォルトでは会話データが学習に利用される仕様です。設定画面の「データ コントロール」から学習をオフにできる点も似ていますが、ChatGPTには「Temporary Chat(一時的なチャット)」という機能があり、これを使うと履歴を残さずに会話ができます。Claudeには現状この機能がないため、アカウント全体での設定が必要です。

また、ChatGPTの法人向けプランである「ChatGPT Enterprise」では、学習に利用しないことが明確に保証されています。基本構造は似ていますが、細かい機能やUIの使い勝手には差があるため、自社の運用ルールに合わせてどちらが管理しやすいかを比較検討するとよいでしょう。

Gemini(Google)の学習設定と比較

GoogleのGeminiは、個人のGoogleアカウントか、企業向けのGoogle Workspaceかによってデータの扱いが大きく異なります。無料版ではGoogleのプライバシーポリシーに基づきデータが活用されることがありますが、Workspaceの有料版(Gemini Business/EnterpriseおよびEducation )では、入力データがモデルの学習に使われないことが保証されています。

既存のGoogleドキュメントなどと同様の堅牢なセキュリティで守られるため、Google製品との親和性を重視する場合はGeminiが有利です。しかし、単体での対話性能や安全性、あるいは特定のベンダーに依存しない構成を求める企業からは、Claudeが選ばれるケースも増えています。

Claudeが「安全」と言われる理由

Claudeは開発元のAnthropic社が「Constitutional AI(憲法AI)」という概念を掲げており、安全性や倫理観を最優先に設計されています。他社AIと比較して、有害な回答やバイアスのかかった回答を生成しにくい構造になっており、企業が導入する際のリスクが相対的に低いと評価されています。

データプライバシーの面でも、法人向けプランでの明確な「学習除外」方針や、API利用時の透明性が高く評価されています。機能面だけでなく、開発元の企業姿勢として「安全第一」を打ち出している点が、セキュリティに厳しい企業からClaudeが選ばれる大きな理由となっているのです。

企業がClaudeを安全に導入・運用するには?

企業としてClaudeを導入する場合、個人の設定任せにするのはリスクが高すぎます。組織全体で統一されたセキュリティ基準を設け、システム的な制限と人的な教育の両面から対策を講じる必要があります。

ここでは、企業が安全にClaudeを活用するための具体的な導入・運用ステップについて解説します。

学習除外のTeamプランを選ぶ

企業での導入において確実な対策は、無料版やPro版ではなく「Teamプラン」以上の法人契約を結ぶことです。Teamプランでは、契約時点で「入力データを学習に利用しない」という条項が含まれているため、社員が個別に設定を変更し忘れるリスクを排除できます。

また、管理者がメンバーを一元管理できるため、退職者のアカウント削除などもスムーズに行えます。コストはかかりますが、情報漏洩事故が起きた際の損害賠償や信用失墜のリスクを考えれば、必要な投資といえます。数名規模のチームであっても、業務利用であればTeamプランの導入を強くおすすめします。

安全な利用ガイドラインを策定する

システム的な対策と並行して、社内での利用ガイドラインを策定することが不可欠です。「入力してよい情報」と「入力してはいけない情報」を具体例とともに明文化しましょう。たとえば、「公開済みのプレスリリースはOKだが、未発表の製品スペックはNG」といった明確な基準が必要です。

ガイドラインは一度作って終わりではなく、AIの機能アップデートに合わせて定期的に見直す必要があります。また、ガイドラインが形骸化しないよう、チャットツールのトップ画面に注意事項を掲示するなど、常に社員の目に入る工夫も効果的でしょう。

社員へのセキュリティ教育を行う

どれほど立派なガイドラインがあっても、社員一人ひとりのセキュリティ意識が低ければ事故は防げません。定期的な研修や勉強会を実施し、生成AIのリスクと正しい使い方を教育する機会を設けてください。「なぜ学習設定をオフにする必要があるのか」を自分事として理解させることが重要です。

また、シャドーIT(会社が許可していないツールを勝手に使うこと)のリスクについても周知が必要です。Claude以外の未承認AIツールを安易に使わないよう、正式な導入ツールとしてClaudeの安全な環境を提供し、そこでの利用を推奨するポジティブなアプローチも有効です。

APIを活用し自社環境を構築する

さらにセキュリティレベルを高めたい場合は、Webブラウザ版ではなく、APIを利用して自社専用のチャット環境を構築する方法があります。Amazon BedrockやGoogle Cloud Vertex AIなどのクラウドプラットフォーム経由でClaudeを利用すれば、データが自社の管理下から出ることなくAIを利用できます。

この方法であれば、ログの保存期間やアクセス権限を自社で完全にコントロールでき、外部へのデータ流出リスクを極限まで低減できます。開発リソースは必要になりますが、機密性の高いデータを扱う金融機関や医療機関、大手企業などでは、このAPI活用モデルが標準的な選択肢となっています。

設定を見直してClaudeを安全に使いましょう

Claudeを安全に利用するためには、まず「学習させない設定」が正しく行われているかを確認することが第一歩です。そのうえで、機密情報のマスキングや不要な履歴の削除といった日々の運用を徹底することで、情報漏洩のリスクは大幅に低減できます。

企業で導入する際は、個人のリテラシーに依存せず、Teamプランの契約やAPI活用による仕組み化を進めることが重要です。便利なAIだからこそ、リスクを正しく理解し、適切な設定とルール作りを行うことで、安心して業務効率化に役立ててください。

※ 掲載している情報は記事更新時点のものです。

※本サイトは、法律的またはその他のアドバイスの提供を目的としたものではありません。当社は本サイトの記載内容(テンプレートを含む)の正確性、妥当性の確保に努めておりますが、ご利用にあたっては、個別の事情を適宜専門家にご相談いただくなど、ご自身の判断でご利用ください。

関連記事

ChatGPTでPDF要約するには?プロンプトやできない時の対処法も紹介

PointChatGPTでPDF要約するには? ChatGPTでPDFを要約する方法は、標準機能の「ファイルアップロード」を利用するのが簡単で高精度です。 推奨する手順:チャット画…

詳しくみるChatGPT Enterpriseとは?料金や企業での活用例を紹介

ChatGPT Enterpriseは、企業利用を前提に設計された最上位プランで、高度なセキュリティとプライバシー保護を備えながら、高性能モデルを無制限に活用できるのが特徴です。個…

詳しくみるChatGPTの音声機能とは?使えるデバイス・活用シーンを紹介

ChatGPTの音声会話機能は、スマートフォンなどのマイクを使ってAIと自然な会話ができる機能です。手を使わずに操作できるため、移動中や作業中でも情報整理や質問、議事録の下書き作成…

詳しくみるYouTube Summary with ChatGPT & Claudeで動画を文字起こし・要約する方法とは?

YouTube Summary with ChatGPT & Claudeを使うと、要約の生成と文字起こし確認により、長時間のYouTube動画でも要点を短時間で把握しやす…

詳しくみるChatGPTで情報漏洩は発生する?対策や安全に利用するポイントを解説

「ChatGPTは便利だから使いたいが、社外秘や個人情報を預けて大丈夫か」と不安を抱く企業は少なくありません。実際には、入力内容・アカウント管理・チャット履歴の扱い方に注意すること…

詳しくみるGemini Nanoとは?特徴やメリット・使い方・活用シーンを解説

Gemini Nanoは、Googleの「Gemini」シリーズの中で、スマホやパソコンなどのデバイス上で直接動作する最小クラスのオンデバイスAIモデルです。テキストの要約・言い直…

詳しくみる