- 更新日 : 2025年12月10日

AIエージェントはツイート分析に使える?主要ツールや導入方法を解説

ツイート(Xの投稿)を分析する手法は、これまで人手による集計や単純なツールに依存していました。しかし、投稿数や拡散速度が増す中で、従来の方法だけでは把握しきれない課題が生まれています。そこで注目されているのが、AIエージェントを用いた自動化されたツイート分析です。AIエージェントはX APIを活用して投稿データを取得し、感情分析やトレンド把握、炎上兆候の検出などを効率的に実現します。

この記事では、AIエージェントでツイート分析を行う際の仕組みや主要ツール、導入ステップ、注意点を体系的に解説します。

※(免責)掲載情報は記事作成日時点のものです。最新の情報は各AIサービスなどの公式サイトを併せてご確認ください。

AIエージェント×ツイート分析の定義

X(旧Twitter)はリアルタイムに膨大な情報が流れるSNSであり、ユーザーの反応や世論の変化をいち早く把握する場として、多くの企業や組織に活用されています。しかし、毎日数百万件に及ぶ投稿を人手で集計・評価するのは現実的ではなく、単純なキーワード検索やエンゲージメント指標の確認だけでは十分なインサイトを得ることができません。

近年はAIの発展により、ツイートを自動で収集・処理・分析する仕組みが実用化され、意思決定に直結する知見を効率的に得られるようになっています。特にAIエージェントを利用した分析は、従来型の分析ツールに比べて柔軟性と自律性が高く、運用の持続性や精度の面でも注目されています。

AIエージェントの定義と役割

AIエージェントとは、単なるプログラムではなく、人間の指示や目標を受けて複数の処理を組み合わせ、自律的に行動できる仕組みを指します。AIエージェントは、外部APIへのアクセス、データの前処理、モデルを使った推論、さらに結果をレポートや通知にまとめるといった一連の流れを一貫して行えます。

ツイート分析においてAIエージェントを活用すれば、「投稿を収集する」「テキストを正規化する」「感情や話題を分類する」「結果を可視化し意思決定者に提示する」といった作業を自動的に進められるのが最大の特徴です。従来の静的なダッシュボードや単純なキーワード集計では得られなかったスピード感と深度を両立できる点で、SNS分析に大きな変革をもたらしています。

ツイート分析で扱うデータ範囲

ツイート分析の対象は本文テキストにとどまりません。ハッシュタグやメンションといった要素は、会話の文脈や影響範囲を理解する上で欠かせない情報です。

投稿の作成時刻、使用されたデバイス、エンゲージメント指標(リポスト数、いいね数、リプライ数など)も定量的な評価に直結します。場合によっては、位置情報や共有されたURLのドメイン、添付された画像・動画の有無も分析対象に含まれます。

AIエージェントはこれら多様なデータを統合的に処理し、単純な言及数だけでは見えない「ユーザー心理の傾向」や「拡散のネットワーク構造」までを明らかにできます。

AIエージェントによるツイート分析のユースケース

AIエージェントを活用したツイート分析の応用範囲は非常に広く、企業活動のさまざまな場面で役立ちます。

マーケティング領域では、新製品やキャンペーンに対する消費者の反応をリアルタイムに把握し、好意的な声と否定的な意見の比率を数値化することで施策の効果検証が可能です。

カスタマーサポートでは、クレームや不満に関する投稿を自動で検出し、早期に対応部署へ通知する仕組みを構築できます。さらにリスクマネジメントの観点では、炎上の兆候を検出して被害を最小限に抑える施策につなげられます。

また、競合ブランドや業界全体に関する議論を分析することで、市場動向を俯瞰し戦略立案に生かすことも可能です。

このようにAIエージェントは、人手では到底追いきれない情報を整理し、実務で活用できる形に変換する役割を担います。

この記事をお読みの方におすすめのガイド4選

続いてこちらのセクションでは、この記事をお読みの方によく活用いただいている人気の資料・ガイドを簡単に紹介します。すべて無料ですので、ぜひお気軽にご活用ください。

※記事の内容は、この後のセクションでも続きますのでぜひ併せてご覧ください。

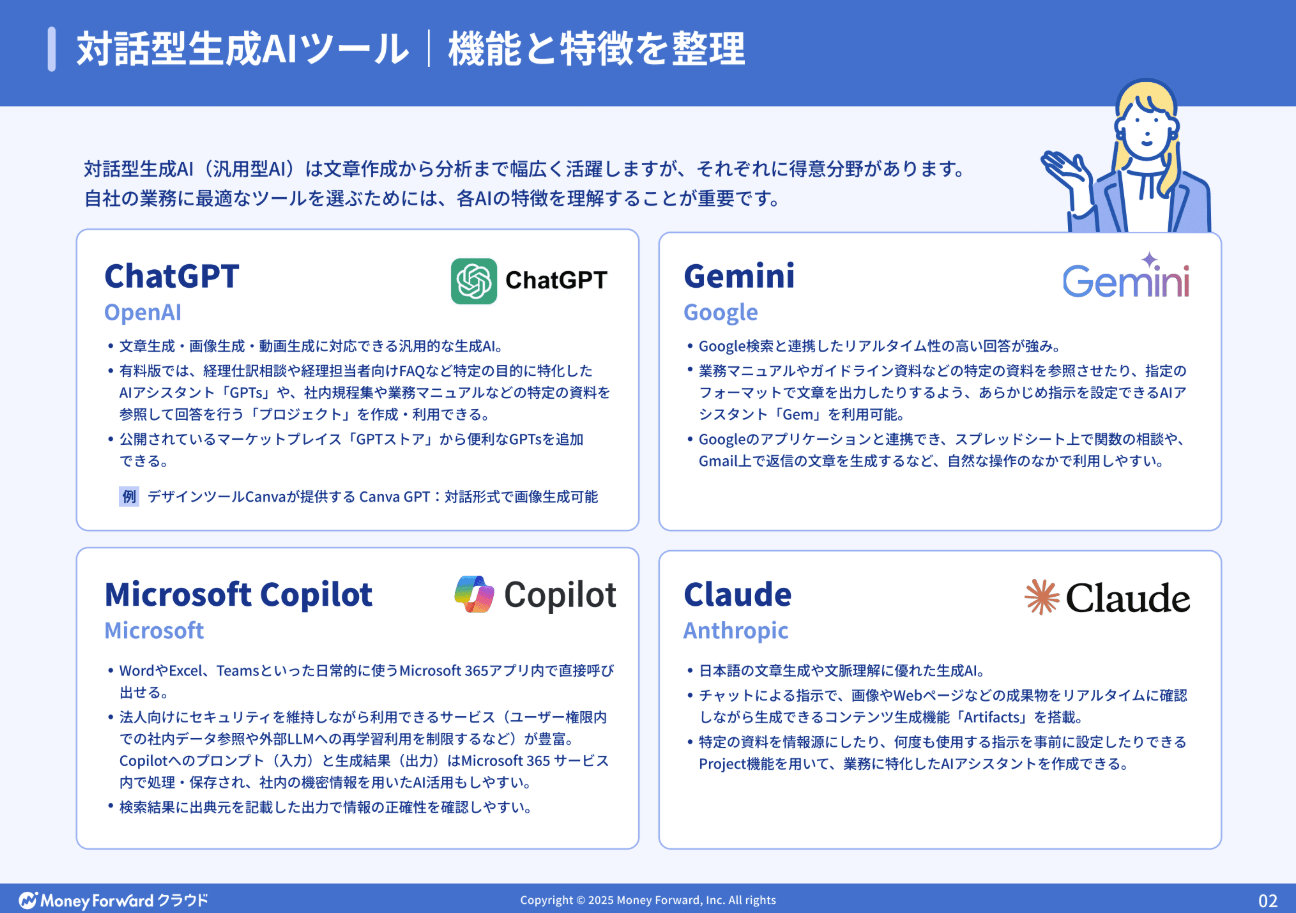

AI活用の教科書

経理・人事・経営企画といった企業の基幹業務における具体的なユースケースをご紹介。

さらに、誰もが均質な成果を出せる「プロンプトのテンプレート化」や、安全なガバナンス構築など、個人利用から企業としての本格活用へステップアップするためのノウハウを凝縮しました。

人事労務担当者向け!Chat GPTの活用アイデア・プロンプトまとめ14選

人事労務業務に特化!人事労務・採用担当者がChat GPTをどのように活用できるのか、主なアイデアを14選まとめたガイドです。

プロンプトと出力内容も掲載しており、PDFからコピペで簡単に試すことも可能です。

経理担当者向け!Chat GPTの活用アイデア・プロンプトまとめ12選

経理業務に特化!経理担当者がChat GPTをどのように活用できるか、主なアイデアを12選まとめたガイドです。

お手元における保存版としてはもちろん、従業員への印刷・配布用としてもぜひご活用ください。

法務担当者向け!Chat GPTの活用アイデア・プロンプトまとめ12選

法務担当者がchat GPTで使えるプロンプトのアイデアをまとめた資料を無料で提供しています。

chat GPT以外の生成AIでも活用できるので、普段利用する生成AIに入力してご活用ください。

X APIの取得条件と前提

ツイート分析をAIエージェントで行うためには、まず公式に提供されているX APIを利用することが前提になります。

Xは膨大な投稿データを持っていますが、外部から自由に収集することはできません。利用者はXが定めたAPIを通じて、認証を済ませた上で定められた条件の範囲内でデータを取得する必要があります。

したがって、「どのエンドポイントを使えるか」「どれくらいの件数を取得できるか」「費用はいくらか」といった要素を事前に理解し、自社の分析目的に合わせて選択することが重要です。

検索エンドポイントの種類

X(旧Twitter)の投稿を分析するには、まず公式のX APIを使う必要があります。中でもよく使われるのが「検索系エンドポイント」です。検索エンドポイントには大きく分けて次の2種類があります。

Recent Search

直近7日間の投稿を対象に検索できるエンドポイントです。特定のキーワードやハッシュタグを条件にして投稿を集めることができます。リアルタイムに近い動きを把握したいときに向いており、まずはここから利用を始めるケースが多いです。

Full-archive Search

過去にさかのぼって投稿を検索できるエンドポイントです。Xが保持している公開投稿をすべて対象にできるため、数年前の発言を分析したいときや長期的なトレンドを見たいときに役立ちます。ただし、ProやEnterpriseといった上位プランでしか利用できません。

どちらも同じ検索クエリの構文を使うため、まずはRecent Searchで試して、必要に応じてFull-archiveへ拡張するのが現実的です。

レート制限と料金

X APIを使う上で注意しなければならないのが「レート制限」と「料金体系」です。

レート制限(リクエスト回数の上限)

例えば、検索APIなら15分間に数百回が上限など、エンドポイントごとに一定時間内で呼び出せる回数が決まっています。制限を超えると「429エラー」が返され、一定時間待たないと再度リクエストできません。そのため、データ収集を自動化する場合は、リトライや再接続の仕組みを組み込む必要があります。

料金プランと月ごとの上限(Post cap)

X APIには利用プランがあり、それぞれで「月に取得できる投稿数」の上限が異なります。代表的なものは以下の通りです。

- Freeプラン:月100件程度の読み取りしかできないため、試用向けのプラン

- Basicプラン:月200ドルで、1.5万件ほどの取得が可能のプラン

- Proプラン:月5,000ドルで、100万件規模の投稿が扱えるプラン

- Enterpriseプラン:専用契約で5,000万件以上を扱える大規模利用者向けのプラン

なお、2024年秋にBasicプランの価格が100ドルから200ドルへ引き上げられたため、今後も料金変更に注意する必要があります。

主要ツールの比較

ツイート分析にAIエージェントを導入する際、どの技術基盤やツールを選ぶかは運用性・柔軟性・コストに直結します。ここでは、Wordware/MonkeyLearn/Grok/ChatGPT の4ツールを、得意領域・制約・導入フェーズなどの観点から比較します。

Wordware

Wordwareは、AIエージェントを設計して運用できるプラットフォームです。専門的なプログラミングをしなくても、画面上で手順を組み合わせて「このときはこう動く」といった流れを作ることができます。

ツイート分析では「X APIからデータを取得→前処理→モデル推論→レポート出力」という一連の流れを自動化できます。条件分岐や繰り返し処理もできるので、ある程度複雑な分析でも対応可能です。

メリットは、ノーコードでも扱いやすく、エージェントをチームで育てていける点です。注意点としては、初期構築の際にはワークフロー設計が必要になるため、ノーコード開発の経験がゼロの場合は習熟に時間がかかります。また、分析そのものは外部のAIモデル(ChatGPTなど)を呼び出すことが多いため、ほかのAIモデルが持つコストや制約の影響を受ける点はデメリットと言えます。

MonkeyLearn

MonkeyLearnは、文章データを手軽に分析できるクラウドサービスです。感情分析やトピック分類といった機能が標準で備わっており、技術的な知識がなくてもすぐに利用できます。

たとえば、X APIで集めたツイートをMonkeyLearnに読み込ませれば、「ポジティブかネガティブか」「どんな話題に分類されるか」といった結果を自動で出せます。さらに、GoogleスプレッドシートやSlackなど他のサービスともつなげやすく、分析結果をすぐに共有できるのも便利です。

メリットは、直感的に使用でき、スピード感を持って始められることです。注意点は、大量データを扱うと制限にかかりやすいことや、特殊な用語やスラングに弱いことです。

Grok

Grokは、xAIが開発したAIモデルで、Xと深く結びついた設計になっています。特徴は「最新の情報や文脈を理解しやすい」点で、質問に答えたり文章をまとめたりするのに向いています。

ツイート分析の場面では、ユーザーの声を素早く要約したり、テーマごとに整理したりするときに役立ちます。APIを通じて使うことができ、利用した分だけ料金を支払う従量課金の仕組みも用意されています。

メリットは、Xとの親和性が高く、リアルタイムの情報に強い可能性があることです。注意点は、安定した提供が契約内容に左右されやすいことや、出力結果の一貫性にばらつきが出ることです。

ChatGPT

ChatGPTは、OpenAIが提供する汎用的なAIサービスで、文章生成や要約、分類など幅広い作業をこなせます。ツイート分析では、CSVやJSON形式で集めたデータを読み込ませて「感情分析」「トピック分類」「傾向の要約」などを行うのが一般的です。

ChatGPTのメリットは、用途が非常に広く柔軟に使用でき、自然な文章で結果をまとめてくれることです。さらに拡張機能(GPTsやエージェント)を使えば、外部のツールやデータベースと連携してより高度な分析が可能になります。

注意点は、大量データを一度に処理しにくいこと、応答の再現性を高めるには工夫が必要なこと、そして利用量が増えるとコストが高くなることです。

AIエージェント導入前の評価軸

AIエージェントをツイート分析に導入する際には、ツールやモデルの選定だけでなく「どのように評価するか」を明確にしておくことが欠かせません。

適切な評価軸を設定せずに導入すると、分析結果が不安定になったり、社内で活用が進まなかったりする可能性があります。ここでは、特に重要な3つの評価軸を解説します。

精度・再現性の評価方法

AIエージェントによるツイート分析の価値は、得られる結果の正確さと一貫性に大きく依存します。単に「モデルが高性能」とされるだけでは十分ではなく、実際のユースケースに即した評価が必要です。

評価にあたっては、あらかじめゴールドデータ(人手でラベル付けしたツイートや既知の分類結果)を用意し、AIエージェントの出力と突き合わせて精度を測定します。感情分析であれば「ポジティブ/ネガティブ/中立」の分類一致率、トピック分析であればテーマごとの正解率やF1スコアを確認します。

さらに重要なのが再現性の検証です。モデルやプロンプトを少し変えただけで結果が大きく揺れるようでは、業務利用に耐えません。定期的に同一データセットを分析し、時系列で出力が安定しているかを確認することが求められます。

特に生成AIを活用する場合は、回答のゆらぎが不可避であるため、複数回の試行を平均化する、あるいは評価基準を明文化するといった工夫が必要です。

データカバレッジと偏りの確認

どれだけ高精度なモデルを使っても、入力となるデータが不十分であれば正しい結論には至りません。そのため、データのカバレッジ(網羅性)と偏りの有無を事前に確認することが不可欠です。

ツイート分析では、使用するAPIの範囲、言語や地域の対象、収集期間などによって得られるデータが大きく変わります。例えば、直近7日間のデータだけでは一時的な話題に強く影響され、長期的なトレンドを把握することは困難です。また、英語や日本語など一部の主要言語に比べ、その他の言語は分析対象から漏れやすく、その結果として全体像に偏りが生じるリスクが高くなるでしょう。

さらに、X APIの仕様上、サンプル取得や制限値によって投稿が部分的に欠落する場合があります。これを放置すると、特定の利用者層や時間帯の投稿が分析結果から抜け落ちてしまう危険があります。したがって、収集条件を明示的に記録し、偏りの有無を定期的に確認することが実務上の必須作業と言えます。

運用性・保守性・拡張性の観点

最後に、システムとして長期的に運用できるかどうかも重要な評価軸です。AIエージェントは一度導入して終わりではなく、継続的に監視・改善することが前提となります。

まず運用性の観点では、APIのレート制限超過や接続断が発生した場合に自動的にリトライできる仕組みがあるか、収集状況やエラーを監視するダッシュボードが整備されているかを確認する必要があります。こうした仕組みがなければ、運用担当者の負担が大きくなり、分析が継続できなくなります。

保守性の観点では、プロンプトや分析ロジックを変更した際に影響範囲を明確にできるか、モデルの更新時に再評価を容易に行えるかが問われます。特に生成AIは定期的にモデルが改良されるため、バージョンが変わったときに以前の結果との比較ができる体制を整えておくことが大切です。

拡張性の観点では、分析対象が増えたときにシステムがスムーズに拡張できるかを見極めましょう。たとえば、最初は感情分析のみだったものを、将来的に「競合比較」や「炎上兆候検出」に広げたい場合、既存フローを再利用できるかが大きな分かれ目になります。また、ダッシュボードや社内システムとの統合可能性も考慮すべきポイントです。

導入ステップ

AIエージェントを用いたツイート分析は、思いつきで始めると失敗につながりやすく、最初の設計段階から明確な流れを踏むことが成功の条件となります。

ここでは、導入の基本ステップを4段階に分けて解説します。

要件定義とKPI設定

まず最初に行うべきは、分析の目的を明確にすることです。AIエージェントは万能ではないため、ゴールが曖昧なままでは期待した成果が得られません。

「何を把握したいのか」「誰が結果を使うのか」を整理し、それに沿ったKPIを設定しましょう。例えば、マーケティング用途であれば「製品名に関する投稿数の推移」や「ポジティブ/ネガティブ比率」、リスク管理用途であれば「クレーム関連投稿の検知数」や「炎上兆候の検出精度」などが該当します。

KPIは定量的で測定可能な指標に落とし込み、ダッシュボードや定期レポートで確認できるようにしておくと、後の運用段階で改善サイクルを回しやすくなります。

データ取得と前処理

要件が定まったら、分析対象のデータを取得します。ここで重要なのは、X APIを適法に利用することです。非公式なスクレイピングは規約違反となるため、必ず認証済みアプリを介してデータを集めます。

取得する際は、Recent Searchで直近のデータを収集するか、Full-archive Searchで過去までさかのぼるかを目的に応じて選択します。さらに、検索クエリで対象の言語やハッシュタグを絞り込むことで、無駄なデータを減らせます。

収集後は前処理を行います。重複の除去、言語の判定、URLの展開、不要な記号やノイズの除去などを標準化することで、分析の再現性が高まります。必要に応じて匿名化処理を加え、プライバシー配慮を徹底することも忘れないようにしましょう。

プロンプト設計と検証

AIエージェントは、与えられた指示(プロンプト)次第で出力内容が大きく変わります。そのため、精度と安定性を担保するには、プロンプトの設計と検証が必須です。

まず、シンプルな指示で試し、期待する出力が得られるかを確認します。次に、分類カテゴリや評価基準を明文化し、曖昧さを減らしたプロンプトを作成します。たとえば「製品Aに対する好意的な意見を抽出し、例文とともに件数を示す」といった具体的な形に落とし込むと、安定した結果が得られやすくなります。

検証段階では、実際のツイートをサンプルとして複数回試行し、出力の一貫性を確認します。誤分類が多いカテゴリについては追加の例文を与えるなど、Few-Shotプロンプティング(AIエージェントにサンプルとなる情報を教えることでパフォーマンスを向上させるプロンプトエンジニアリングの手法)を行うと改善につながります。

運用・モニタリング・改善

導入後は、AIエージェントを放置せず、定期的に監視と改善を行うことが求められます。

運用の基本は、精度の維持・データ取得の安定性・システム稼働状況の3点をモニタリングすることです。具体的には、APIの利用量やレート制限の状況、収集データ数、感情分類の精度などをダッシュボードで可視化し、異常があれば通知する仕組みを整えます。

改善の観点としては、定期的にKPIを振り返り、モデルやプロンプトの調整を行うことが重要です。新しいスラングやトレンドが登場すれば、辞書や学習例を更新する必要があります。また、ユーザー部門からのフィードバックを取り入れ、レポート形式や可視化の改善を重ねることで、組織全体での活用度を高められます。

さらに、規模拡大に伴って処理量が増える場合は、データ保存基盤やワークフローの最適化を検討します。クラウドサービスやエージェント開発基盤を組み合わせることで、負荷分散や拡張性を確保できるでしょう。

リスクと注意事項

AIエージェントでツイート分析を導入する際は、技術的な利便性だけでなく、法的リスクや倫理的課題を十分に理解しておく必要があります。データの扱い方や結果の信頼性を軽視すると、企業活動そのものに影響が及びかねません。ここでは特に重要な2つのリスク領域を整理します。

プライバシー・法務・利用規約

ツイートは公開されているとはいえ、利用条件はXが定める開発者規約に従う必要があります。非公開情報を取得する行為や、スクレイピングで大量に収集する方法は規約違反となり、アカウント停止や法的措置の対象となる可能性があります。また、取得したデータを第三者に再配布することも制限されているため、用途を明確にし、組織内でのみ利用する体制を整えることが重要です。

さらに、投稿内容には個人情報やセンシティブな情報が含まれる場合があります。分析結果をレポート化する際は、ユーザー名や位置情報を特定できないように匿名化や集計処理を行い、プライバシーに十分配慮しなければなりません。特に欧州のGDPR、日本の個人情報保護法など、地域ごとの規制に沿った対応を行うことが必須です。

バイアス・ハルシネーション対策

AIモデルには学習データの偏りが反映されやすく、結果にもバイアスが含まれることがあります。特に、特定の地域や言語に偏ったデータしか扱っていない場合、全体像を正確に表さない分析結果が出力される可能性があります。また、生成AIは「ハルシネーション」と呼ばれる誤情報の出力を起こすことがあるため、無条件に信用するのは危険です。

バイアスやハルシネーションのリスクを低減するためには、まず分析の前提条件やデータ範囲を明示することが大切です。さらに、サンプルデータを人手で確認し、AI出力と突き合わせるプロセスを導入すると信頼性が高まります。

炎上検知やネガティブ分析のように判断を誤ると影響が大きい領域では、最終的な確認を人間が行う二重チェック体制が望ましいでしょう。出力に根拠を示させるプロンプトを設計し、数値や例文を含む回答を求めることも、信頼性を高める有効な手段です。

AIエージェントによりSNS業務を効率化しよう

AIエージェントを活用したツイート分析は、マーケティングやカスタマーサポート、リスクマネジメントにおいて大きな力を発揮します。人手では処理しきれない大量の投稿を継続的に分析し、リアルタイムで有益な知見を抽出できることが最大の魅力です。

ただし、その導入にはリスク管理と運用設計が欠かせません。利用規約の遵守、プライバシー保護、出力精度の検証といった基礎をしっかり押さえることで、安心して活用を続けられます。正しいプロセスを踏んでAIエージェントを導入すれば、SNS運用は単なる情報収集から、戦略的な意思決定を支える仕組みへと進化します。今後は、小規模な実証から始め、段階的に機能を拡張していくことが現実的で効果的なアプローチになるでしょう。

※ 掲載している情報は記事更新時点のものです。

※本サイトは、法律的またはその他のアドバイスの提供を目的としたものではありません。当社は本サイトの記載内容(テンプレートを含む)の正確性、妥当性の確保に努めておりますが、ご利用にあたっては、個別の事情を適宜専門家にご相談いただくなど、ご自身の判断でご利用ください。

関連記事

経費精算AIエージェントとは?仕組みやメリット、選び方まで徹底解説

Point経費精算AIエージェントとは? 経費精算AIエージェントとは、AIが自律的に申請データの作成・精査・不備指摘を行うソフトウェアです。 自動入力と精査:領収書画像から費目を…

詳しくみるAIエージェントの作り方を初心者向けに解説!無料で試す方法や活用方法

PointAIエージェントの作り方とは? AIエージェントの作り方は、目的の明確化から始まり、ノーコードツールやプログラミングを用いて思考・判断・実行のプロセスを設計する一連の手順…

詳しくみる年末調整 AIエージェントとは?仕組みやできることをわかりやすく解説

Point年末調整AIエージェントとは? 年末調整AIエージェントとは、AIが自律的に申告内容の不備を検知し、従業員との対話や書類の自動読み取りを通じて業務を完結させる次世代の自動…

詳しくみる最新AI「Gemini 2.5 Pro」とは?料金、使い方、1.5 Proとの違いまで徹底解説

Gemini 2.5 Proは、Googleが開発した最新かつ最上位のAIモデルであり、有料プラン「Google AI Pro」もしくは「Google AI Ultra」によって提…

詳しくみる議事録AIエージェントおすすめ比較9選!効果的な活用法も合わせて解説

Point議事録AIエージェントとは? 議事録AIエージェントは、会議の文字起こしだけでなく、文脈を理解して要約やネクストアクションの抽出を自律的に行うシステムです。 自律的な構造…

詳しくみるGensparkのAIエージェントとは?特徴やできることをわかりやすく解説

PointGenspark AIエージェントとは Gensparkは、複数のAIが連携して情報の調査・計画・実行を自律的に行い、構造化された専用ページを生成する次世代のAIエージェ…

詳しくみる