- 作成日 : 2026年1月14日

ChatGPTのAPIとは?できることや始め方・使い方を解説

ChatGPTのOpenAI APIは、生成AI「ChatGPT」を自社システムや業務アプリに組み込み、文章生成や要約、分類などを自動化できる開発者向けの仕組みです。ブラウザで使うChatGPTとは異なり、業務フローに直接組み込める点が大きな特徴で、社内問い合わせ対応や資料作成支援、FAQ生成など幅広い用途で活用されています。

当記事では、ChatGPTのAPIの基本的な仕組みやできること、料金の考え方、トークン使用量を抑える工夫などを解説します。生成AIを「試す段階」から「実務で使いこなす段階」へ進めたい方に役立つ内容です。

※(免責)掲載情報は記事作成日時点のものです。最新の情報は各AIサービスなどの公式サイトを併せてご確認ください。

目次

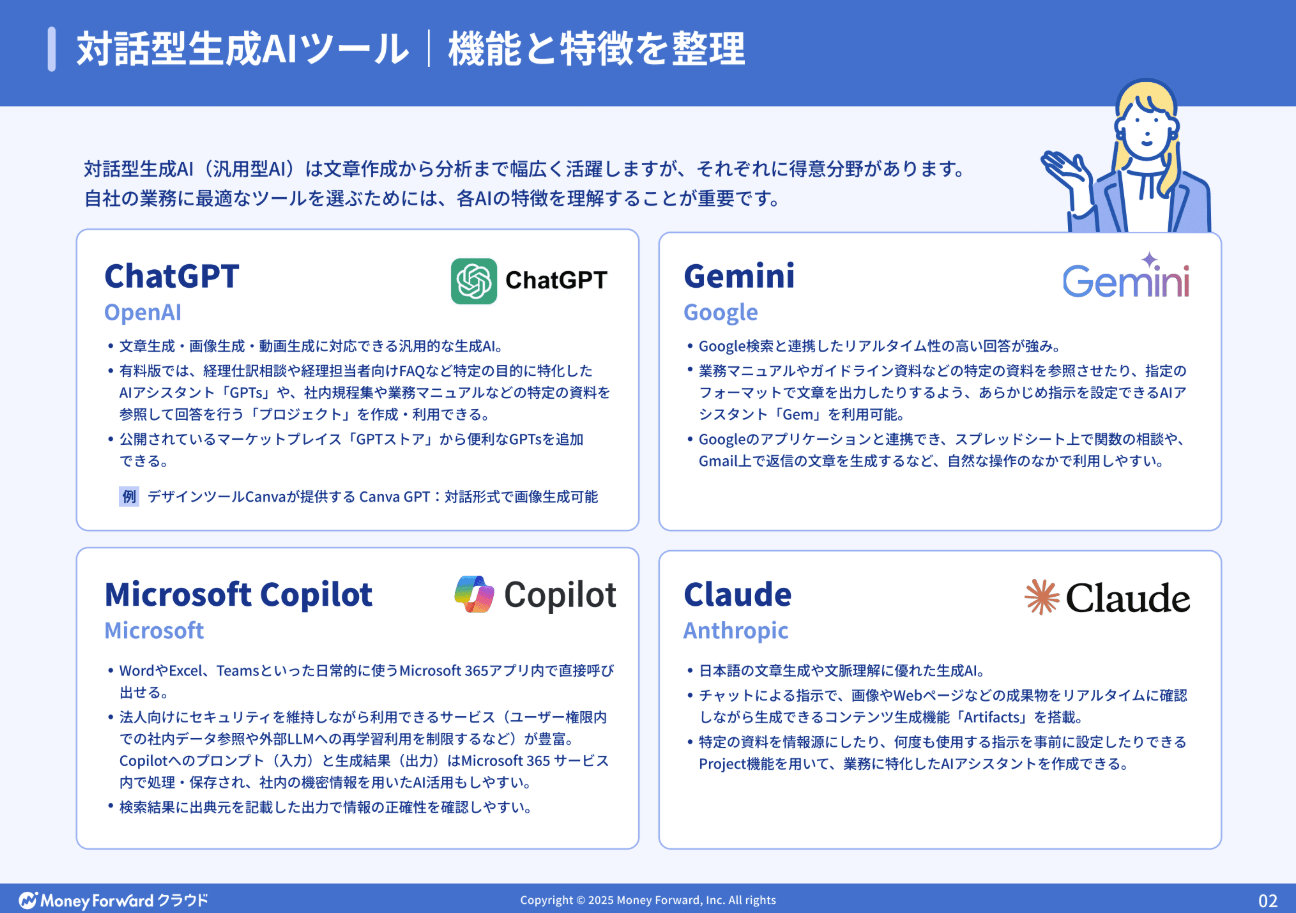

経理担当者が実務ですぐに使える、ChatGPT・Gemini・Claude・Copilotなど最新の生成AI10種の特徴比較と業務別の使い分けをまとめた保存版資料。

社内ルール整備のポイントも掲載。ぜひ 無料ダウンロードしてご活用ください。

ChatGPTのAPIとは?

ChatGPTのAPI(OpenAI API)とは、OpenAIが提供する生成AI「ChatGPT」を、自社システムや業務アプリケーションに組み込むための開発者向けインターフェースです。

Web画面で使うChatGPTとは異なり、APIを利用することで、チャットボット、文章生成、要約、分類などの機能を業務フローに直接組み込めます。たとえば、社内問い合わせ対応の自動化、議事録作成支援、FAQ生成などに活用可能です。

APIは従量課金制で、利用量に応じてコスト管理がしやすい点も特徴です。業務効率化やDX推進を目的に、生成AIを安全かつ柔軟に活用したいビジネスパーソンにとって、ChatGPTのAPIは実用性の高い選択肢だと言えるでしょう。

ChatGPTのAPIの仕組み

ChatGPTのAPIは、テキストなどの入力(リクエスト)を送信すると、AIが処理して結果(レスポンス)を返す仕組みです。

開発者はHTTPリクエストを通じて、指示文や質問文をAPIに渡します。すると、OpenAIのサーバー上で大規模言語モデルが推論を行い、生成されたテキストがJSON形式で返却されます。この一連の流れは数秒以内で完了し、リアルタイム処理にも対応できます。

処理量は「トークン」という単位で計測され、入力と出力の合計に基づいて課金されます。仕組み自体はシンプルなため、専門的なAI知識がなくても、既存システムと連携しやすい点が強みです。

ChatGPTのAPIとChatGPTの違い

ChatGPTのAPIとChatGPTの最大の違いは、「業務システムに組み込めるかどうか」です。

ChatGPTはブラウザやアプリ上で対話的に使うツールで、個人利用や情報収集に向いています。一方、ChatGPTのAPIはプログラムから呼び出して使うため、社内ツールや顧客向けサービスへの組み込みが可能です。また、APIではプロンプト設計や出力形式を細かく制御でき、ログ管理や自動処理にも適しています。

業務で継続的に生成AIを活用したい場合は、再現性と拡張性に優れるChatGPTのAPIのほうが適していると言えるでしょう。

この記事をお読みの方におすすめのガイド4選

続いてこちらのセクションでは、この記事をお読みの方によく活用いただいている人気の資料・ガイドを簡単に紹介します。すべて無料ですので、ぜひお気軽にご活用ください。

※記事の内容は、この後のセクションでも続きますのでぜひ併せてご覧ください。

AI活用の教科書

経理・人事・経営企画といった企業の基幹業務における具体的なユースケースをご紹介。

さらに、誰もが均質な成果を出せる「プロンプトのテンプレート化」や、安全なガバナンス構築など、個人利用から企業としての本格活用へステップアップするためのノウハウを凝縮しました。

人事労務担当者向け!Chat GPTの活用アイデア・プロンプトまとめ14選

人事労務業務に特化!人事労務・採用担当者がChat GPTをどのように活用できるのか、主なアイデアを14選まとめたガイドです。

プロンプトと出力内容も掲載しており、PDFからコピペで簡単に試すことも可能です。

経理担当者向け!Chat GPTの活用アイデア・プロンプトまとめ12選

経理業務に特化!経理担当者がChat GPTをどのように活用できるか、主なアイデアを12選まとめたガイドです。

お手元における保存版としてはもちろん、従業員への印刷・配布用としてもぜひご活用ください。

法務担当者向け!Chat GPTの活用アイデア・プロンプトまとめ12選

法務担当者がchat GPTで使えるプロンプトのアイデアをまとめた資料を無料で提供しています。

chat GPT以外の生成AIでも活用できるので、普段利用する生成AIに入力してご活用ください。

ChatGPTのAPIでできることは?

ChatGPTのAPIを使うことで、文章生成を中心とした多様な業務を自動化・効率化できます。

具体的には、問い合わせ対応用のチャットボット構築、メール文や提案書の下書き作成、長文資料の要約、FAQやマニュアルの自動生成などが可能です。また、入力された文章を分類したり、指定したルールに沿って言い換えたりする用途にも向いています。

既存の業務システムやCRM、社内ツールと連携しやすく、人の作業工程に自然に組み込める点や、出力形式や文字数を制御し業務品質を一定に保ちやすい点もメリットです。生成AIを「試す段階」から「実務で使う段階」へ進めたい企業にとって、ChatGPTのAPIは汎用性の高い基盤となるでしょう。

ChatGPTのAPIの始め方は?

ChatGPTのAPIは、OpenAIアカウントの作成から開発環境の準備まで、いくつかの基本手順を踏めば利用を開始できます。特別なAIの専門知識がなくても、公式ドキュメントに沿って設定すれば導入は難しくありません。

ここでは、初めてChatGPTのAPIを使う方に向けて、アカウント作成から実装準備までの流れを順を追って解説します。

OpenAIアカウントの作成

ChatGPTのAPIを利用するには、まずOpenAIの公式サイトでアカウントを作成します。メールアドレス、Googleアカウント、Microsoftアカウントなどを使って登録でき、個人でも法人でも作成可能です。

登録後はメール認証を行い、管理画面(ダッシュボード)にログインできる状態にします。このダッシュボードから、APIキーの管理や利用状況の確認が行えます。業務利用の場合は、社用メールアドレスで登録しておくと、後の権限管理や引き継ぎがしやすくなります。

支払い方法の登録

ChatGPTのAPIは従量課金制のため、事前に支払い方法の登録が必要です。OpenAIのダッシュボードから、クレジットカード情報を登録します。利用料金は、実際に使用したトークン量に応じて月次で請求される仕組みです。ダッシュボードであらかじめ月次予算や通知しきい値を設定して利用状況を監視できるため、想定外の高額請求を防ぐことも可能です。

業務利用では、少額の上限から試験導入し、問題なければ徐々に引き上げる方法が一般的です。コスト管理の観点からも、早い段階で設定を確認しておきましょう。

APIキーの発行

APIキーは、ChatGPTのAPIを利用するための「認証情報」にあたります。ダッシュボードの設定画面から新しいAPIキーを発行すると、英数字の文字列が生成されます。このキーをプログラムに設定することで、OpenAIのAPIを呼び出せるようになります。

APIキーは第三者に漏れると不正利用のリスクがあるため、ソースコードに直接書き込まず、環境変数などで安全に管理しましょう。また、不要になったキーは削除できるため、定期的な見直しも大切です。

SDKのインストール

ChatGPTのAPIは、公式SDKを使うことで簡単にプログラムから呼び出せます。PythonやNode.js向けのSDKが提供されており、パッケージ管理ツールを使って数行のコマンドで導入可能です。

SDKを利用すると、HTTP通信を意識せずにAPIを扱えるため、実装ミスを減らせます。業務アプリや検証用スクリプトを素早く作成したい場合は、SDKの活用が効率的です。公式ドキュメントに対応バージョンや注意点がまとめられているため、事前に確認してから活用しましょう。

開発環境の設定

最後に、APIを実行するための開発環境を整えます。PCにPythonやNode.jsをインストールし、先ほど発行したAPIキーを環境変数として設定します。その上で、テキスト生成などの簡単なサンプルコードを実行し、正常にレスポンスが返るかを確認します。

ここまで完了すれば、ChatGPTのAPIを使った開発準備は整った状態です。まずは小さな処理から試し、業務への適用範囲を徐々に広げていくと、失敗のリスクを抑えられます。

Responses APIで最小コードを実行する

Responses APIは、テキスト生成に加えてWeb検索やFile Search、リモートMCPなどのツールも統合した、OpenAI APIの主要エンドポイントです。

APIは外部のサービスをプログラムから呼び出すための仕組みを指しますが、Responses APIでは、AIに渡す入力(プロンプト)と、AIから返ってくる出力(レスポンス)を最小構成で扱えます。

ここでは、Responses APIの基本的な処理の流れを整理した上で、PythonとNode.jsそれぞれの実行イメージを解説します。

最小リクエストの流れ

Responses APIの基本的な流れは、「リクエストを送信し、レスポンスを受け取る」という構造です。

まず、プログラム側からOpenAIのAPIに対してリクエスト(処理依頼)を送ります。このリクエストには、使用するモデル名と、AIに指示するテキスト(入力文)が含まれます。APIはその内容を受け取り、OpenAIのサーバー上で推論処理を行います。推論とは、入力内容をもとにAIが最適な文章を生成する処理のことです。処理結果はレスポンスとして返され、JSON形式のデータの中に生成されたテキストが含まれます。

最小構成では、会話履歴や詳細な設定は不要で、単発の質問と回答を確認するだけで十分です。

Pythonでの実行例

Pythonでは、公式SDKを使うことで比較的少ないコード量でResponses APIを実行できます。SDKとは、APIを簡単に使うための補助ツールです。

Python用SDKをインストールし、APIキー(認証用の文字列)を環境変数に設定します。その後、OpenAIクライアントを初期化し、Responses APIに入力テキストを渡します。例えば「社内向けのお知らせ文を作成してください」といった指示を送ると、AIが文章を生成して返します。返却されるレスポンスには、生成結果のほか、トークン使用量などの情報も含まれます。

Node.jsでの実行例

Node.jsでも、Responses APIの考え方はPythonと共通しています。Node.jsはJavaScriptでサーバー側の処理を書くための実行環境です。SDKをインストールし、APIキーを設定した上で、非同期処理としてResponses APIを呼び出します。非同期処理とは、処理の完了を待ちながら他の作業も進められる仕組みを指します。APIに入力文を送信すると、AIが生成したテキストを含むレスポンスが返ってきます。

Node.jsはWebアプリや業務システムと連携しやすいため、生成AIを組み込んだサービス開発にも向いています。

応答の受け取り方を確認する

ChatGPTのAPIを業務で活用するためには、AIが返してくる「応答(レスポンス)」の中身を正しく理解することが重要です。Responses APIでは、生成された文章だけでなく、処理結果に関するさまざまな情報がまとめて返されます。

ここでは、レスポンスに含まれるoutputの基本構造を確認し、必要なテキストを取り出す方法、さらにエラーが発生した場合の見方を解説します。応答の構造を理解しておくことで、トラブル時の原因特定や、安定した業務実装につながります。

outputの基本構造

Responses APIの返却データでは、生成結果は「output」という項目にまとめられています。

outputは配列形式になっており、その中にAIの処理結果が複数の要素として格納されます。各要素には「どの種類の出力か」を示す情報が含まれており、テキスト生成の場合は、生成された文章データがさらに内部に入っています。

少し複雑にも思えますが、「outputの中にAIの結果がまとまっている」と理解しておけば問題ありません。

テキストの取り出し方

生成された文章は、output内のテキスト要素から取得します。多くの場合、SDKではoutput_textのような補助的なプロパティが用意されており、生成された文章だけを簡単に取り出せます。これは、複雑な構造を意識せずに済むため、初心者には特に便利です。

一方で、より細かい制御が必要な場合は、output配列を直接確認し、テキスト部分を指定して取得する方法もあります。業務システムでは、取得したテキストを画面表示やファイル出力、他の処理への受け渡しに利用します。

エラー時の見方

API呼び出しで問題が発生した場合、レスポンスや例外情報から原因を確認できます。

たとえば、APIキーが間違っている場合や、利用上限を超えた場合には、エラーコードとエラーメッセージが返されます。これらの情報には、「どこで」「なぜ」問題が起きたのかが簡潔に示されています。

開発初期によくあるのは、APIキー未設定や権限不足によるエラーです。エラー内容を確認し、設定や入力内容を見直すことで多くは解決できます。業務利用では、エラー発生時のログを残しておくと、原因調査や再発防止に役立ちます。

ツール連携の使い方

ChatGPTのAPIは、文章生成だけでなく「外部ツール」と連携させることで、より実務に近い処理が可能です。

ツール連携とは、AIが文章を返すだけでなく、関数の実行や検索、ファイル参照などを行える仕組みです。ここでは代表的な4つの連携方法について、役割と使いどころを分かりやすく解説します。

Function Calling

Function Callingは、AIが「どの処理を実行すべきか」を判断し、事前に定義した関数を呼び出す仕組みです。

あらかじめプログラム側で関数の名前や引数の形式を定義しておくと、AIはユーザーの入力内容を理解し、適切な関数を選択します。これにより、AIが自由に文章を生成するのではなく、決められた業務処理に安全に誘導できます。業務ロジックはプログラム側、判断はAIに任せる構成になるため、実務システムとの相性が良い点が特徴です。

Web Search

Web Searchは、AIが最新情報を取得するためにWeb検索結果を参照できる仕組みです。

通常の生成AIは、学習時点までの知識しか持っていませんが、Web Searchを使うことで、公開情報を検索し、その内容をもとに回答を生成できます。たとえば、最新ニュースや制度変更、一般公開されている企業情報などを扱う場合に有効です。

業務利用では、調査や情報収集の補助として活用されるケースが多く、検索結果をそのまま使うのではなく、要約や整理をAIに任せる形が一般的です。ただし、情報の正確性は最終的に人が確認する前提で使用しましょう。

File Search

File Searchは、あらかじめ登録したファイルの中身をAIが参照できるようにする機能です。

社内マニュアル、規程、FAQ、過去の資料などをアップロードしておくことで、AIはそれらの内容を検索し、回答に反映できます。これにより、「社内ルールに基づいた回答」や「資料に沿った説明」が可能です。特に社内問い合わせ対応やヘルプデスク業務で効果を発揮する機能で、業務知識をAIに持たせたい場合に欠かせません。

MCP

MCP(Model Context Protocol)は、AIと外部システムを標準化された方法で接続するための仕組みです。MCPを使うと、データベースや業務アプリケーションなどを「AIが使えるツール」として定義できます。これにより、AIは外部システムの情報を参照したり、処理結果を受け取ったりできます。

Function Callingと似ていますが、MCPはより汎用的で、複数のツールやサービスを統一的に扱える点が特徴です。将来的にAI連携を拡張していく前提のシステムでは、MCPを意識した設計を行うことで、保守性や拡張性を高められます。

ストリーミング応答の使い方

ストリーミング応答は、AIの生成結果を「まとめて受け取る」のではなく、「生成される途中から順番に受け取る」仕組みです。

通常のAPI呼び出しでは、AIの処理が完了してから結果が返りますが、ストリーミングを使うと、画面に文字が少しずつ表示されるような体験を実現できます。ここでは、ストリーミング応答の基本的な考え方と、実装時に知っておきたいポイントを解説します。

ストリーミングの基本

ストリーミングとは、AIの応答を分割されたデータとして順次受け取る方式です。

通常のレスポンスは1回でまとめて返されますが、ストリーミングでは、生成途中のテキストが小さな単位で送信されます。これにより、ユーザーは待ち時間を短く感じやすくなります。

チャットアプリや問い合わせ対応画面など、「今処理中であること」を見せたい場面に向いていますが、すべての生成が終わったかどうかを判定する処理も必要になるため、通常の応答より実装はやや複雑になります。

実装例

ストリーミング応答は、SDKのストリーミング機能を使って実装します。

PythonやNode.jsのSDKでは、ストリーミング専用のオプションやメソッドが用意されています。これを使うと、AIから送られてくるテキストの断片を順番に受け取り、画面表示やログ出力に反映できます。たとえば、受信した文字列をそのまま画面に追加表示することで、チャット風のUIを実現できます。

実装時は、「どのタイミングで表示するか」「生成完了をどう判断するか」を意識することが重要です。最初は簡単な表示確認から始めると理解しやすくなります。

ストリーミングの注意点

ストリーミング応答には、便利な反面、注意すべき点もあります。ストリーミング応答では、途中経過がそのまま表示されるため、内容の途中修正や出力制御がしにくい点には注意が必要です。また、通信が途中で切れた場合、完全な文章を受け取れない可能性もあります。

業務利用では、最終結果を確定させてから保存や処理を行う仕組みを用意すると安全です。さらに、ログ管理やエラー処理も通常より複雑になるため、リアルタイム性が本当に必要かを見極めた上で導入しましょう。

【2025年版】ChatGPTのAPIの料金体系は?

ChatGPTのAPIの料金は「使った分だけ支払う」従量課金制で、モデルの種類とトークン使用量によって決まります。

トークンとは、AIが処理する文字量の単位で、入力(Input)と出力(Output)の合計が課金対象です。2025年時点では、用途に応じてテキスト特化モデル、推論に強いモデル、画像や音声を扱えるマルチモーダルモデルなどが用意されています。ここでは代表的なモデル区分ごとに、特徴と料金の目安を紹介します。

なお、最新の価格は公式サイトをご確認ください。

テキストモデルの価格

テキストモデルは、文章生成・要約・分類など、一般的な業務用途に使われるモデルです。代表的なモデルとしては、gpt-5.2、gpt-5.1、gpt-5-miniなどがあります。

たとえば、gpt-5.2は高性能なテキストモデルで、入力は100万トークンあたり1.75ドル、出力は14.00ドルです。一方、軽量なgpt-5-miniでは、入力が0.25ドル、出力が2.00ドルと、コストを大きく抑えられます。

大量の文章処理や定型業務には、miniやnano系を選ぶことで費用対効果を高めやすくなります。

推論モデルの価格

推論モデルは、複雑な判断や高度な思考を必要とする処理に向いています。o1やo3といったモデルが該当し、計画立案や分析系のタスクで使われることが多いです。

o3は入力が100万トークンあたり2.00ドル、出力が8.00ドルと、比較的バランスの取れた価格設定です。一方、より高度な推論性能を持つo1-proは、入力150.00ドル、出力600.00ドルと高額になります。推論モデルは高性能な分コストも高いため、必要な場面に限定して使う設計を行いましょう。

マルチモーダルモデルの価格

マルチモーダルモデルは、テキストだけでなく画像・音声などを扱える点が特徴で、代表例としてgpt-4oやgpt-audioがあります。

gpt-4oの場合、テキスト入力は100万トークンあたり2.50ドル、出力は10.00ドルです。音声を扱うgpt-audioでは、音声入力が32.00ドル、音声出力が64.00ドルと、テキストより高めの価格設定になっています。マルチモーダルモデルは、チャットUIや音声対応サービスなど、付加価値の高い用途で使われるケースが一般的です。

バッチ処理の価格

バッチ処理は、大量のリクエストをまとめて実行することでコストを抑えられる方式です。

通常のリアルタイム処理に比べ、優先度を下げて実行する代わりに、入力単価が大幅に安く設定されています。

たとえば、gpt-5.2のBatchでは、100万トークンあたり入力0.875ドル・出力7.00ドル(Standard)と、標準(入力1.75ドル・出力14.00ドル)の半額程度になります。大量の文章生成や夜間処理、分析用途など、即時性が不要な業務では非常に有効です。コスト削減を重視する場合は、バッチ処理の活用を前提に設計すると効果的です。

ChatGPTのAPIのトークン使用量を減らす方法は?

ChatGPTのAPIを業務で安定して使うには、トークン使用量を意識した設計が欠かせません。トークンは入力・出力の両方で消費されるため、使い方次第でコストに大きな差が出ます。特に業務システムでは、同じ処理を何度も実行したり、長文を扱ったりするケースが多く、無駄なトークン消費が起こりやすい点に注意が必要です。

ここでは、実装面で取り入れやすいトークン削減の具体策を紹介します。

履歴の要約

長い会話履歴をそのまま送信せず、要約してから渡すことでトークンを大幅に削減できます。

チャット形式のシステムでは、過去のやり取りをすべてAPIに送ると、入力トークンが急増します。そこで有効なのが、一定のやり取りごとに内容を要約し、要点だけを次回以降の入力に含める方法です。履歴をすべて保持する必要がない業務では、要約を前提とした設計にすることで、コストと処理効率の両方を改善できます。

出力長の制御

出力の文字数を制限することで、不要なトークン消費を防げます。APIでは、出力トークンの上限を指定できるため、「必要以上に長い回答」が返ってくるのを防止できます。業務用途では、簡潔な要約や定型文が求められるケースが多く、長文はかえって使いにくくなることもあります。

あらかじめ適切な出力長を決めておくことで、読みやすさとコストの両立が可能になります。

内部処理の英語化

AIへの内部指示を英語にすることで、トークン数を抑えられる場合があります。一般に、同じ意味内容であれば、日本語より英語のほうがトークン数が少なくなる傾向があります。そのため、ユーザー向けの出力は日本語のままにしつつ、内部の指示文や処理用プロンプトだけを英語にする方法が有効です。

実装上は少し工夫が必要ですが、継続利用する業務システムでは効果が積み重なります。

キャッシュの活用

同じ入力に対する結果を再利用することで、API呼び出し回数そのものを減らせます。キャッシュとは、一度得た結果を保存し、次回以降はAPIを呼ばずに使う仕組みです。

たとえば、定型的な質問や頻繁に使う文章生成結果は、毎回AIに問い合わせる必要はありません。特にFAQ生成やテンプレート作成などでは、キャッシュを活用することでトークン消費を大幅に削減できます。

コスト削減だけでなく、レスポンス速度の向上にもつながる点がメリットです。

バッチ処理の活用

即時性が不要な処理は、バッチ処理にまとめることでコストを抑えられます。バッチ処理では、複数のリクエストをまとめて低価格で実行できます。たとえば、夜間に大量の文章要約や分類を行う場合、リアルタイムAPIを使うより効率的です。トークン単価が安く設定されているため、同じ処理でも費用を抑えられます。

業務要件に応じて、リアルタイム処理とバッチ処理を使い分けることが、API活用を長期的に続けるポイントです。

ChatGPTのAPIの特徴と使い方のコツ

ChatGPTのAPIは、生成AIを業務システムに組み込み、文章生成や要約、問い合わせ対応などを効率化できる実践的なAPIです。APIの仕組みやResponses APIの基本、ツール連携、ストリーミング応答などを理解することで、単なる文章生成にとどまらず、実務に即した活用が可能になります。

ChatGPTのAPIを活用する上で大切なのは、高性能なモデルを闇雲に使うのではなく、用途に応じて最適な使い方を選ぶことです。ChatGPTのAPIを正しく理解し、段階的に導入を進めることで、業務効率化と生成AI活用の効果を最大化できるでしょう。

※ 掲載している情報は記事更新時点のものです。

※本サイトは、法律的またはその他のアドバイスの提供を目的としたものではありません。当社は本サイトの記載内容(テンプレートを含む)の正確性、妥当性の確保に努めておりますが、ご利用にあたっては、個別の事情を適宜専門家にご相談いただくなど、ご自身の判断でご利用ください。

関連記事

ChatGPT GPTsとは?使い方や作成手順、注意点など解説

PointChatGPT GPTsとは? GPTsとは、プログラミング不要で自分専用のChatGPTを作成・共有できるカスタム機能のことです。 最大の特徴:特定の役割や独自データを…

詳しくみるChatGPTのタスク機能とは?使い方・できること・活用例を分かりやすく解説

ChatGPTのタスク機能(Tasks)は、指定した時刻(単発/定期)などをトリガーに、あらかじめ登録したプロンプトを自動で実行し、結果を通知(プッシュ通知/メール)できる機能です…

詳しくみるClaude Opus 4.5とは?特徴から活用方法、登録手順まで解説

PointClaude Opus 4.5とは? Claude Opus 4.5とは、複雑な課題解決と自律操作に特化したAnthropic社の最上位モデルです。 特徴:PC操作を自律…

詳しくみる高性能モデルClaude 4(Opus・Sonnet)とは?活用方法を解説

Claude 4は、Anthropic社が開発した最新世代の大規模言語モデルであり、安全性と高精度な自然言語処理を両立している点が最大の特徴です。ビジネスや研究での活用を前提に設計…

詳しくみるChatGPTの共有方法は?スマホの手順やできない時の対処法を解説

ChatGPTの共有機能は、作成したチャットの履歴を専用のURLで第三者に手軽に送れる便利な仕組みです。ビジネスでの情報共有やノウハウの伝達に役立ちますが、設定を間違えると個人情報…

詳しくみるCopilot Editsとは?利用環境や起動・作業方法を解説

仕様変更やリファクタリングで複数ファイルを直すと、影響範囲の見落としやレビュー負荷が増えがちです。Copilot Editsは変更案をまとめて提示し、差分を見て採用可否を選べるため…

詳しくみる